print( *( Augen := [6, 2, 1, 2] ) )

print(f"Das Würfelergebnis an Indexposition 2 lautet: {Augen[2]}")6 2 1 2

Das Würfelergebnis an Indexposition 2 lautet: 12016 stellte eine Studie fest, dass ein Fünftel aller wissenschaftlichen Artikel im Bereich der Genetik auf der Grundlage von durch die Tabellenkalkulation Excel verfälschten Daten durchgeführt wurde (Ziemann, Eren, und El-Osta 2016). Genbezeichnungen wie “MARCH1” wurden fälschlicherweise in ein Datumsformat umgewandelt. 2021 wurde diese Schätzung des Anteils betroffener Arbeiten sogar auf 30 Prozent angehoben. (heise online)

Am Beginn der computergestützten Datenanalyse steht das Einlesen von Daten aus Dateien. In der Praxis ist das Einlesen von Daten alles andere als trivial. Daten werden in einer Vielzahl von Dateiformaten gespeichert. Deshalb ist es in der Datenanalyse erforderlich, mit verschiedenen Dateiformaten umgehen zu können: mit wenigen Kilobyte großen Textdateien, offenen und proprietären Formaten gängiger Büroanwendungen und mehreren hundert Megabyte großen Dateien in speziell für den Austausch wissenschaftlicher Daten entwickelten Formaten. Programmiersprachen wie Python und R bringen verschiedene Werkzeuge zum Lesen, Bearbeiten und Speichern von verschiedenen Dateiformaten mit. Spezialisierte Pakete ergänzen den Werkzeugkasten.

Die praktischen Herausforderungen der Datenanalyse beschränken sich jedoch nicht nur auf technische Aspekte. Oftmals bereitet der innere Aufbau von Datensätzen die größten Schwierigkeiten. Ein wichtiger Bestandteil des Einlesens strukturierter Datensätze besteht darin, Fehler im Datensatz zu suchen und ggf. zu bereinigen. Dasu und Johnson schreiben:

“Unfortunately, the data set is usually dirty, composed of many tables, and has unknown properties. Before any results can be produced, the data must be cleaned and explored—often a long and difficult task. […] In our experience, the tasks of exploratory data mining and data cleaning constitute 80% of the effort that determines 80% of the value of the ultimate data mining results.” (Dasu und Johnson (2003), S. ix)

Das Einlesen strukturierter Datensätze umfasst somit den gesamten Prozess des technischen Zugriffs auf Dateien, der Organisation, Fehlersuche und -korrektur sowie des Abspeicherns der Daten in einer für die weitere Bearbeitung geeigneten Form.

In der praktischen Datenanalyse helfen zwei einfache Tipps beim Einlesen strukturierter Datensätze:

Schauen Sie sich Ihre Daten an, bevor Sie diese mit Python einlesen! Dafür reicht ein Texteditor oder ein Tabellenkalkulationsprogramm (hier die automatische Erkennung und Umwandlung von Datumsformaten beachten). Ein kurzer Blick genügt, um die verwendeten Zeichentrenner, Tausendertrennzeichen, Datumsformate, die Kodierung fehlender Werte und die Unicode-Kodierung (wie UTF-8) zu identifizieren.

Dies ist aber nicht immer möglich, beispielsweise wenn Ihr Datensatz aus hunderten Spalten und zehntausenden Zeilen besteht. Dieser Baustein vermittelt deshalb die Handwerkszeuge, um Datensätze ausschließlich mit den in Python verfügbaren Mitteln einzulesen.

Es ist nicht erforderlich, die Besonderheiten aller hier vorgestellten Pakete und Funktionen auswendig zu beherrschen. Dafür ist das Themenfeld zu komplex und nicht selten ändert sich das Verhalten von Funktionen mit der Weiterentwicklung der Programmiersprache. Die hier vorgestellten Besonderheiten von Funktionen dienen jedoch als mentale Ankerpunkte, die als Anknüpfungspunkt dienen sollen, wenn Sie in der Praxis auf Probleme stoßen.

Benutzen Sie die Dokumentation! Auf diese Weise erhalten Sie einen vollständigen Überblick über standardmäßig gesetzte und optional verfügbare Parameter. Außerdem erkennen Sie Änderungen in der Programmausführung und vermeiden so unerwartete Fehler.

Bevor wir uns mit den praktischen Herausforderungen des Einlesens strukturierter Datensätze beschäftigten, werden zunächst einige Merkmale von Datensätzen behandelt, um ein grundlegendes Verständnis der Begrifflichkeiten zu schaffen und den Umgang der in der Basis von Python enthaltenen Werkzeuge zu vermitteln. Am Ende dieses Kapitels wird mit tidy data ein grundlegendes Konzept zur Organisation von Datensätzen vorgestellt.

Ein Datensatz ist eine Sammlung zusammengehöriger Daten. Datensätze enthalten einer oder mehreren Variablen zugeordnete Werte. Jeder Datensatz besitzt ein technisches Format, eine Struktur, mindestens eine Variable und mindestens einen Wert.

Das technische Format eines Datensatzes gibt vor, mit welchen Mitteln Daten eingelesen, bearbeitet und gespeichert werden können. Einige Beispiele sind:

Druckerzeugnis, z. B. Telefonbuch: manuelles Ablesen von Name und Telefonnummer, irreversible Bearbeitung per Stift

Lochkarte, z. B. Parkschein: Lesegerät erkennt Lochung und gewährt eine Freistunde, irreversible Bearbeitung mit Stanzgerät

Textdatei, z. B. Einwohnerzahl nach Bundesländern: Kann mit einer Vielzahl von Computerprogrammen wie Texteditor, Tabellenkalkulationsprogramm oder Programmierumgebung eingelesen, bearbeitet und gespeichert werden.

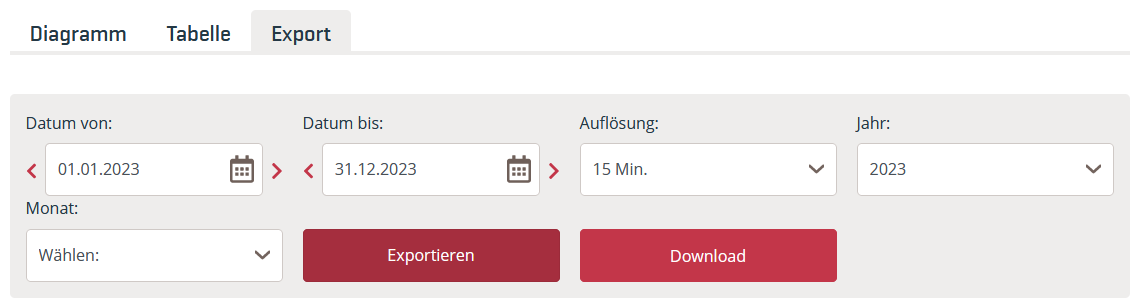

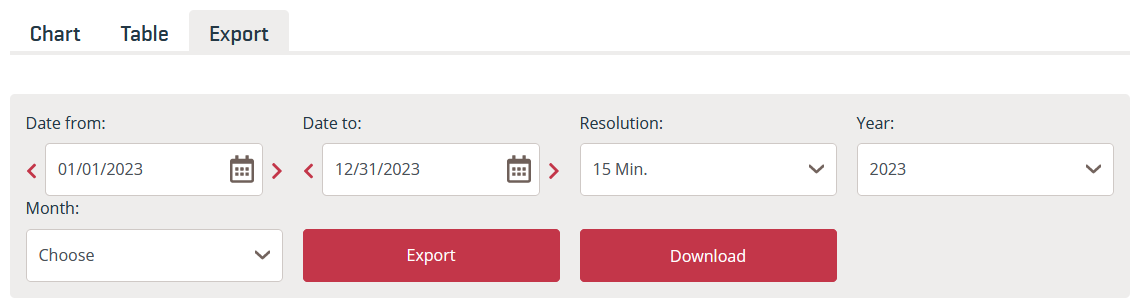

Hierarchical Data Format HDF5, z. B. räumliche Daten zur Blitzdichte: benötigt spezialisierte Programme oder Pakete

Datensätze speichern Daten in einer definierten n-dimensionalen Struktur.

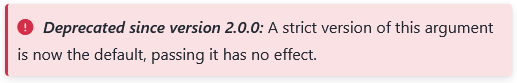

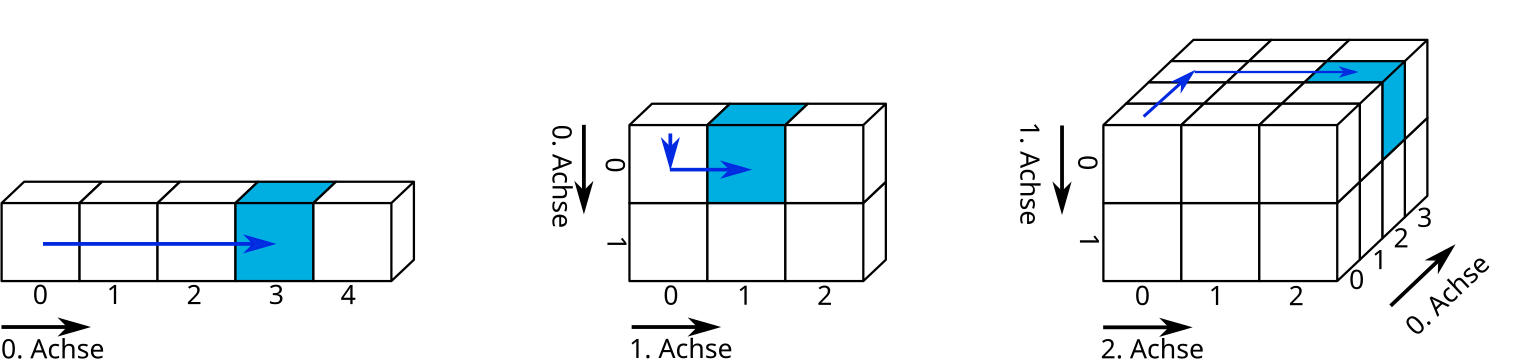

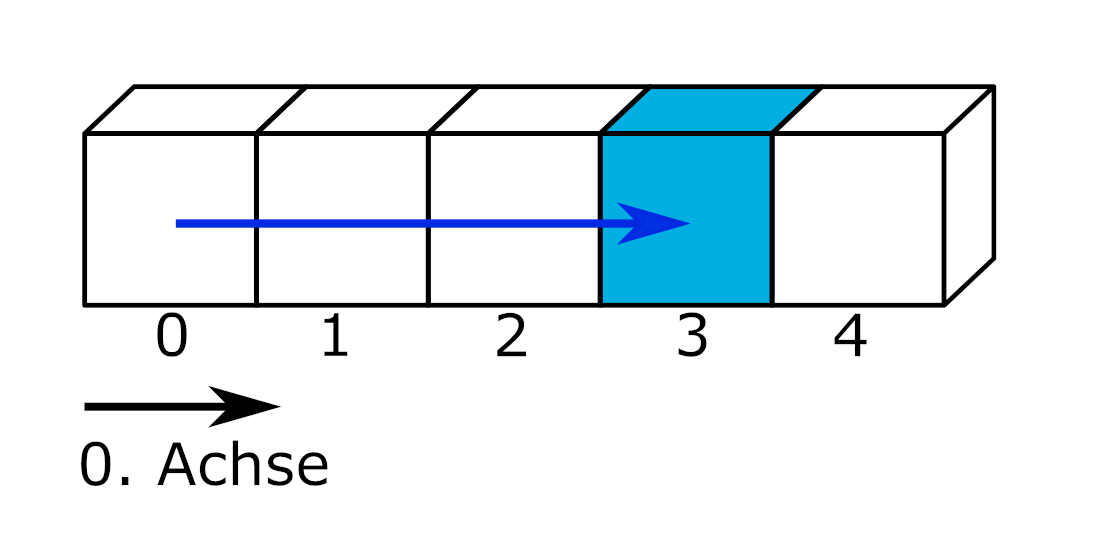

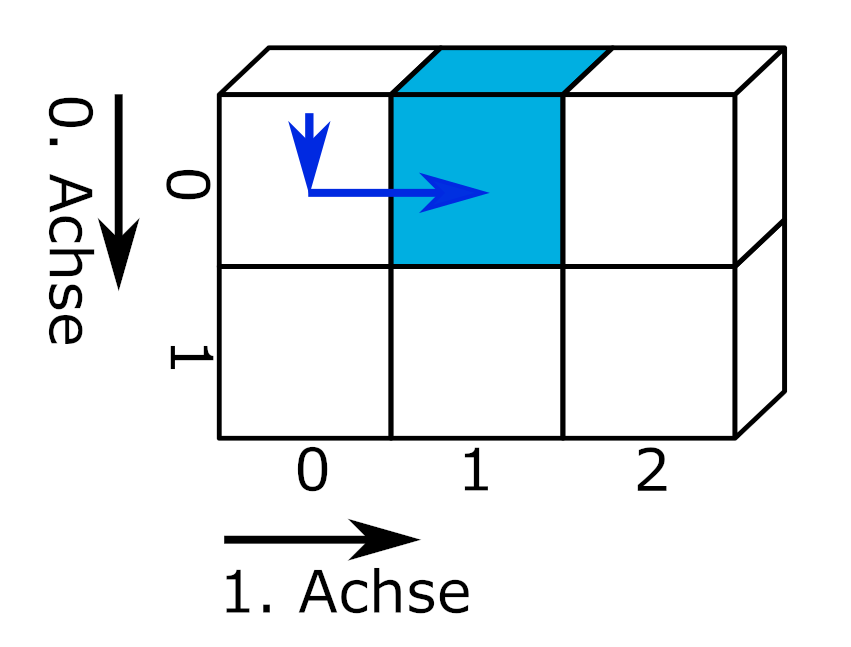

slicing von Marc Fehr ist lizensiert unter CC-BY-4.0 und abrufbar auf GitHub. 2024

Die einfachste Form sind eindimensionale Datensätze, die Werte einer einzigen Variablen zuordnen. Eindimensionale Datensätze mit Werten des gleichen Typs (bspw. Zahlen) werden Vektor genannt. Eindimensionale Datensätze, die unterschiedliche Datentypen enthalten können, heißen Liste. Eindimensionale Datensätze verfügen lediglich über eine Achse: den Index, über den Elemente angesprochen werden können.

slicing von Marc Fehr ist lizensiert unter CC-BY-4.0 und abrufbar auf GitHub. Die Grafik wurde auf den gezeigten Teil beschnitten und die obenstehende Beschriftung entfernt. 2024

Beispiele eindimensionaler Datensätze sind ein Einkaufszettel oder die Urliste eines Würfelexperiments. Über den Index kann beispielsweise das Würfelergebnis an der Indexposition 2 ausgegeben werden.

print( *( Augen := [6, 2, 1, 2] ) )

print(f"Das Würfelergebnis an Indexposition 2 lautet: {Augen[2]}")6 2 1 2

Das Würfelergebnis an Indexposition 2 lautet: 1An dieser Stelle eine kleine Wiederholung aus dem Werkzeugbaustein Python:

Die Pythonbasis greift über Dateiobjekte auf Dateien zu. Die Funktionen und Methoden haben Sie im Querverweis auf w-python kennengelernt. Der Zugriff auf Dateien über die Pythonbasis ist eine verlässliche Rückfalloption und darüber hinaus nützlich, um die Enkodierung einer Datei zu bestimmen.

os.getcwd() aus dem Modul os gibt das aktuelle Arbeitsverzeichnis aus, mit der Funktion os.cwd(pfad) kann es gewechselt werden.open(dateipfad, mode = 'r') öffnet eine Datei im Lesemodus und gibt ein Dateiobjekt zurück.dateiobjekt.name, os.path.basename(dateiobjekt.name), dateiobjekt.closed, dateiobjekt.mode, dateiobjekt.encodingdateiobjekt.read(), dateiobjekt.readline(), dateiobjekt.readlines() oder der Funktion list(dateiobjekt) ausgelesen werden.dateiobjekt.close() schließt die Datei und gibt sie somit wieder für andere Programme frei.Lesen Sie die Datei “python.txt” unter dem dateipfad “skript/01-daten/” ein.

Bestimmen Sie die Enkodierung der Datei.

Entfernen Sie die die erste Zeile aus dem Text und geben Sie den Text mit Python aus.

Wie kann der Text korrekt dargestellt werden?

dateipfad = "01-daten/" + "python.txt"

dateiobjekt = open(dateipfad, mode = 'r')

# Enkodierung der Datei bestimmen

print(f"Die Enkodierung der Datei lautet: {dateiobjekt.encoding}")

# Text ausgeben

text_als_liste = list(dateiobjekt)

for i in range(1, len(text_als_liste)):

print(text_als_liste[i])

# Datei schließen.

dateiobjekt.close()Die Enkodierung der Datei lautet: UTF-8

Python ist eine universell nutzbare, üblicherweise interpretierte, höhere Programmiersprache.[14] Sie hat den Anspruch, einen gut lesbaren, knappen Programmierstil zu fördern.[15] So werden beispielsweise Blöcke nicht durch geschweifte Klammern, sondern durch Einrückungen strukturiert.

Python wurde mit dem Ziel größter Einfachheit und Übersichtlichkeit entworfen. Dies wird vor allem durch zwei Maßnahmen erreicht. Zum einen kommt die Sprache mit relativ wenigen Schlüsselwörtern aus.[49] Zum anderen ist die Syntax reduziert und auf Übersichtlichkeit optimiert. Dadurch lassen sich Python-basierte Skripte deutlich knapper formulieren als in anderen Sprachen.[50]

Van Rossum legte bei der Entwicklung großen Wert auf eine Standardbibliothek, die überschaubar und leicht erweiterbar ist. Dies war Ergebnis seiner schlechten Erfahrung mit der Sprache ABC, in der das Gegenteil der Fall ist.[51] Dieses Konzept ermöglicht, in Python Module aufzurufen, die in anderen Programmiersprachen geschrieben wurden, etwa um Schwächen von Python auszugleichen. Beispielsweise können für zeitkritische Teile in maschinennäheren Sprachen wie C implementierte Routinen aufgerufen werden.

Auszug aus https://de.wikipedia.org/wiki/Python_(Programmiersprache), abgerufen am 20.02.2025Enkodierung UTF-8 auswählen.

# Mit europäischen Sonderzeichen kompatible Enkodierung UTF-8 wählen

dateiobjekt = open(dateipfad, mode = 'r', encoding = 'utf-8')

# Text ausgeben

text_als_liste = list(dateiobjekt)

for i in range(1, len(text_als_liste)):

print(text_als_liste[i])

# Datei schließen.

dateiobjekt.close()

Python ist eine universell nutzbare, üblicherweise interpretierte, höhere Programmiersprache.[14] Sie hat den Anspruch, einen gut lesbaren, knappen Programmierstil zu fördern.[15] So werden beispielsweise Blöcke nicht durch geschweifte Klammern, sondern durch Einrückungen strukturiert.

Python wurde mit dem Ziel größter Einfachheit und Übersichtlichkeit entworfen. Dies wird vor allem durch zwei Maßnahmen erreicht. Zum einen kommt die Sprache mit relativ wenigen Schlüsselwörtern aus.[49] Zum anderen ist die Syntax reduziert und auf Übersichtlichkeit optimiert. Dadurch lassen sich Python-basierte Skripte deutlich knapper formulieren als in anderen Sprachen.[50]

Van Rossum legte bei der Entwicklung großen Wert auf eine Standardbibliothek, die überschaubar und leicht erweiterbar ist. Dies war Ergebnis seiner schlechten Erfahrung mit der Sprache ABC, in der das Gegenteil der Fall ist.[51] Dieses Konzept ermöglicht, in Python Module aufzurufen, die in anderen Programmiersprachen geschrieben wurden, etwa um Schwächen von Python auszugleichen. Beispielsweise können für zeitkritische Teile in maschinennäheren Sprachen wie C implementierte Routinen aufgerufen werden.

Auszug aus https://de.wikipedia.org/wiki/Python_(Programmiersprache), abgerufen am 20.02.2025Zweidimensionale Datensätze organisieren Werte in einer aus Zeilen und Spalten bestehenden Matrix oder einem Dataframe. Eine Matrix enthält nur einen Datentyp (bspw. Zahlen), ein Dataframe kann unterschiedliche Datentypen enthalten (bspw. Zahlen und Wahrheitswerte). In Python stellt das Modul Pandas die DataFrame-Struktur bereit. [hier Querverweis auf w-Pandas]

slicing von Marc Fehr ist lizensiert unter CC-BY-4.0 und abrufbar auf GitHub. Die Grafik wurde auf den gezeigten Teil beschnitten und die obenstehende Beschriftung entfernt. 2024

Typischerweise entspricht in zweidimensionalen Datensätzen jede Spalte einer Variablen und jede Zeile einer Beobachtung. Variablen speichern alle Werte eines Merkmals, zum Beispiel des Würfelergebnisses. Beobachtungen speichern alle Werte, die für eine Beobachtungseinheit gemessen wurden, z. B. für eine Person. (Wickham 2014, 3)

import pandas as pd

messung1 = pd.DataFrame({'Name': ['Hans', 'Elke', 'Jean', 'Maya'], 'Geburtstag': ['26.02.', '14.03.', '30.12.', '07.09.'], 'Würfelfarbe': ['rosa', 'rosa', 'blau', 'gelb'], 'Summe Augen': [17, 12, 8, 23]})

messung1| Name | Geburtstag | Würfelfarbe | Summe Augen | |

|---|---|---|---|---|

| 0 | Hans | 26.02. | rosa | 17 |

| 1 | Elke | 14.03. | rosa | 12 |

| 2 | Jean | 30.12. | blau | 8 |

| 3 | Maya | 07.09. | gelb | 23 |

Über die Angabe der Indizes entlang der 0. (Zeilen) und der 1. Achse (Spalten) kann die Summe der gewürfelten Augen einer Person ausgegeben werden.

print(f"Jean würfelte {messung1.iloc[2, 3]} Augen")Jean würfelte 8 AugenEs ist aber auch möglich, zunächst eine Spalte auszuwählen und dann wie bei einem eindimensionalen Datensatz den Wert an einer Indexposition aufzurufen. Dies wird verkettete Indexierung genannt.

print(f"Jean würfelte {messung1['Summe Augen'][2]} Augen")Jean würfelte 8 AugenDie verkettete Indexierung erzeugt in Pandas abhängig vom Kontext eine Kopie des Objekts oder greift auf den Speicherbereich des Objekts zu. Mit Pandas 3.0 wird die verkettete Indexierung nicht mehr unterstützt, das Anlegen einer Kopie wird zum Standard werden. Weitere Informationen erhalten Sie im zitierten Link.

“Whether a copy or a reference is returned for a setting operation, may depend on the context. This is sometimes called chained assignment and should be avoided. See Returning a View versus Copy.”

Zweidimensionale Datensätze werden zumeist in einer aus Zeilen und Spalten bestehenden Matrix dargestellt. Den zeilenweise eingetragenen Beobachtungen werden Werte für die in den Spalten organisierten Variablen zugeordnet. Diese Art Daten darzustellen, wird wide-Format genannt: Mit jeder zusätzlich gemessenen Variablen wird der Datensatz breiter.

Eine andere Art Daten zu organisieren und über Daten nachzudenken, ist die Darstellung im long-Format. Einige Programme und Pakete erfordern Daten im long-Format oder profitieren zumindest davon beispielsweise bei der Erstellung von Grafiken. Schauen wir uns zunächst noch einmal den Datensatz messung1 im wide-Format an. Welche Beobachtungseinheiten gibt es? Welche Variablen wurden erhoben?

| Name | Geburtstag | Würfelfarbe | Summe Augen | |

|---|---|---|---|---|

| 0 | Hans | 26.02. | rosa | 17 |

| 1 | Elke | 14.03. | rosa | 12 |

| 2 | Jean | 30.12. | blau | 8 |

| 3 | Maya | 07.09. | gelb | 23 |

Vermutlich werden Sie davon ausgehen, dass die Beobachtungseinheiten Hans, Elke, Jean und Maya sind und die Variablen Geburtstag, Würfelfarbe und Summe Augen. Es ist aber auch denkbar, dass die Beobachtungseinheit Person mit 0, 1, 2 und 3 kodiert wurde (dem Zeilenindex des Datensatzes) und die Spalte Name ebenfalls eine der erhobenen Variablen ist. Ebenso könnte es nur zwei Variablen, Würfelfarbe und Summe Augen, geben, während die Spalten Name und Geburtstag die beobachteten Personen kodieren. Stellen Sie sich vor, es gäbe eine zweite Person mit dem Namen Hans. Dann könnten die Würfelergebnisse der Personen mit dem Namen Hans nur über den Geburtstag am 26.02. oder 11.11. korrekt zugeordnet werden.

messung1 = pd.DataFrame({'Name': ['Hans', 'Elke', 'Jean', 'Maya', 'Hans'], 'Geburtstag': ['26.02.', '14.03.', '30.12.', '07.09.', '11.11.'], 'Würfelfarbe': ['rosa', 'rosa', 'blau', 'gelb', 'rosa'], 'Summe Augen': [12, 17, 8, 23, 7]})

messung1| Name | Geburtstag | Würfelfarbe | Summe Augen | |

|---|---|---|---|---|

| 0 | Hans | 26.02. | rosa | 12 |

| 1 | Elke | 14.03. | rosa | 17 |

| 2 | Jean | 30.12. | blau | 8 |

| 3 | Maya | 07.09. | gelb | 23 |

| 4 | Hans | 11.11. | rosa | 7 |

Das long-Format macht diese Überlegungen explizit, indem identifizierende Variablen (identification variables, kurz: id vars) und gemessene Variablen (measure variables oder value vars) unterschieden werden. Die Transformation eines Datensatzes aus dem wide-Format ins long-Format wird melting (schmelzen) genannt. Das Modul Pandas bietet die Funktion pd.melt(frame, id_vars = None). Diese erwartet einen DataFrame. Im optionalen Argument id_vars wird angegeben, welche Spalten die identifizierenden Variablen sind.

messung1_long = pd.melt(messung1, id_vars = ['Name', 'Geburtstag'])

messung1_long| Name | Geburtstag | variable | value | |

|---|---|---|---|---|

| 0 | Hans | 26.02. | Würfelfarbe | rosa |

| 1 | Elke | 14.03. | Würfelfarbe | rosa |

| 2 | Jean | 30.12. | Würfelfarbe | blau |

| 3 | Maya | 07.09. | Würfelfarbe | gelb |

| 4 | Hans | 11.11. | Würfelfarbe | rosa |

| 5 | Hans | 26.02. | Summe Augen | 12 |

| 6 | Elke | 14.03. | Summe Augen | 17 |

| 7 | Jean | 30.12. | Summe Augen | 8 |

| 8 | Maya | 07.09. | Summe Augen | 23 |

| 9 | Hans | 11.11. | Summe Augen | 7 |

Im long-Format werden die gemessenen Variablen in der Spalte variable aufgeführt und deren Wert in der Spalte value eingetragen. Mit jeder zusätzlich erhobenen Variablen wird der Datensatz länger.

Wenn Sie die Unterscheidung von identifizierenden und gemessenen Variablen zu Ende denken, kann der Variablenname selbst als eine identifizierende Variable für den Wert in der Spalte value aufgefasst werden. Ein Datensatz kann als eine Struktur verstanden werden, die genau eine gemessene Variable, nämlich value, und eine Anzahl identifizierender Variablen besitzt. Dies kann im long-Format wie folgt dargestellt werden.

messung1_all_id = pd.melt(messung1, id_vars = ['Name', 'Geburtstag', 'Würfelfarbe'])

messung1_all_idIn dieser Darstellung wird beispielsweise der erste Wert 12 durch Name = Hans, Geburtstag = 26.02., Würfelfarbe = rosa und variable = Summe Augen identifiziert.

| Name | Geburtstag | Würfelfarbe | variable | value | |

|---|---|---|---|---|---|

| 0 | Hans | 26.02. | rosa | Summe Augen | 12 |

| 1 | Elke | 14.03. | rosa | Summe Augen | 17 |

| 2 | Jean | 30.12. | blau | Summe Augen | 8 |

| 3 | Maya | 07.09. | gelb | Summe Augen | 23 |

| 4 | Hans | 11.11. | rosa | Summe Augen | 7 |

Much wow. Such architecture. von Dmitry Kudryavtsev ist verfügbar unter https://yieldcode.blog/post/bloat-in-software-engineering/. Das Bild wird wahrscheinlich wieder entfernt.

Was passiert, wenn auch die Variable Summe Augen dem Argument id_vars übergeben wird?

Der Befehl messung1_all_id = pd.melt(messung1, id_vars = ['Name', 'Geburtstag', 'Würfelfarbe', 'Summe Augen']) produziert einen leeren Dataframe, weil keine gemessenen Werte verbleiben.

Auch der umgekehrte Fall ist möglich: Werden beim melting keine id_vars angegeben, werden alle Spalten als gemessene Variablen behandelt.

messung1_no_id = pd.melt(messung1)

messung1_no_id| variable | value | |

|---|---|---|

| 0 | Name | Hans |

| 1 | Name | Elke |

| 2 | Name | Jean |

| 3 | Name | Maya |

| 4 | Name | Hans |

| 5 | Geburtstag | 26.02. |

| 6 | Geburtstag | 14.03. |

| 7 | Geburtstag | 30.12. |

| 8 | Geburtstag | 07.09. |

| 9 | Geburtstag | 11.11. |

| 10 | Würfelfarbe | rosa |

| 11 | Würfelfarbe | rosa |

| 12 | Würfelfarbe | blau |

| 13 | Würfelfarbe | gelb |

| 14 | Würfelfarbe | rosa |

| 15 | Summe Augen | 12 |

| 16 | Summe Augen | 17 |

| 17 | Summe Augen | 8 |

| 18 | Summe Augen | 23 |

| 19 | Summe Augen | 7 |

Die Umkehroperation zum melting wird casting (gießen) oder pivoting (schwenken) genannt. Dabei wird ein im long-Format vorliegender Datensatz in das wide-Format konvertiert. Die Pandas Funktion pd.pivot(data, columns, index) nimmt einen melted DataFrame entgegen und konveriert diesen aus den einzigartigen Werten in columns (= Spaltennamen des DataFrame im wide-Format) und den einzigartigen Werten in index (= Zeilenindex des DataFrame im wide-Format). Wird der Funktion keine Spalte für index übergeben, wird der bestehende Index des melted DataFrame verwendet (der mit 20 Zeilen natürlich viel zu lang ist.) Da das Objekt messung1_no_id keine geeignete Indexspalte besitzt, muss diese vor dem casting erzeugt werden. Dies ist mit der Methode messung1_no_id.groupby('variable').cumcount() möglich, die die Anzahl jeder Ausprägung in der übergebenen Spalte bei 0 beginnend durchzählt. (Ein direktes Ersetzen des Index ist auf diese Weise nicht möglich, da der Index des an pd.pivot(data, columns, index) übergebenen DataFrames keine Doppelungen enthalten darf.)

# pd.pivot() benötigt einen Index oder benutzt den bestehenden Index, des melted_df, der zu lang ist

# Deshalb eine zusätzliche Spalte in messung1_no_id einfügen

## einfach: messung1_no_id['new_index'] = list(range(0, 5)) * 4

## allgemein: messung1_no_id['new_index'] = messung1_no_id.groupby('variable').cumcount()

# Spalte new_index einfügen

messung1_no_id['new_index'] = messung1_no_id.groupby('variable').cumcount()

print (f"Der Datensatz im long-Format mit zusätzlicher Spalte new_index:\n{messung1_no_id}")

# casting

messung1_cast = pd.pivot(messung1_no_id, index = 'new_index', columns = 'variable', values = 'value')

print(f"\nDer Datensatz im wide-Format:\n{messung1_cast}")Der Datensatz im long-Format mit zusätzlicher Spalte new_index:

variable value new_index

0 Name Hans 0

1 Name Elke 1

2 Name Jean 2

3 Name Maya 3

4 Name Hans 4

5 Geburtstag 26.02. 0

6 Geburtstag 14.03. 1

7 Geburtstag 30.12. 2

8 Geburtstag 07.09. 3

9 Geburtstag 11.11. 4

10 Würfelfarbe rosa 0

11 Würfelfarbe rosa 1

12 Würfelfarbe blau 2

13 Würfelfarbe gelb 3

14 Würfelfarbe rosa 4

15 Summe Augen 12 0

16 Summe Augen 17 1

17 Summe Augen 8 2

18 Summe Augen 23 3

19 Summe Augen 7 4

Der Datensatz im wide-Format:

variable Geburtstag Name Summe Augen Würfelfarbe

new_index

0 26.02. Hans 12 rosa

1 14.03. Elke 17 rosa

2 30.12. Jean 8 blau

3 07.09. Maya 23 gelb

4 11.11. Hans 7 rosaDas Ergebnis entspricht noch nicht dem ursprünglichen Datensatz im wide-Format. Um das Ausgangsformat wiederherzustellen, müssen die Spalten in die ursprüngliche Reihenfolge gebracht sowie der Index und dessen Beschriftung zurückgesetzt werden.

# Spalten anordnen, Index zurücksetzen

messung1_cast = messung1_cast[['Name', 'Geburtstag', 'Würfelfarbe', 'Summe Augen']]

messung1_cast.reset_index(drop = True, inplace = True)

messung1_cast.rename_axis(None, axis = 1, inplace = True)

print(f"\nDer Datensatz im wide-Format mit zurückgesetztem Index:\n\n{messung1_cast}")

Der Datensatz im wide-Format mit zurückgesetztem Index:

Name Geburtstag Würfelfarbe Summe Augen

0 Hans 26.02. rosa 12

1 Elke 14.03. rosa 17

2 Jean 30.12. blau 8

3 Maya 07.09. gelb 23

4 Hans 11.11. rosa 7Auch wenn Sie mit Datensätzen im wide-Format arbeiten, ist die Unterscheidung identifizierender und gemessener Variablen nützlich, um Datensätze zu organisieren. siehe 2.5

Oben wurde das Objekt messung1_long mit dem Befehl messung1_long = pd.melt(messung1, id_vars = ['Name', 'Geburtstag']) angelegt.

Benutzen Sie die Funktion pd.DataFrame.pivot(), um den Datensatz messung1 wieder ins wide-Format zu transformieren.

| Name | Geburtstag | variable | value | |

|---|---|---|---|---|

| 0 | Hans | 26.02. | Würfelfarbe | rosa |

| 1 | Elke | 14.03. | Würfelfarbe | rosa |

| 2 | Jean | 30.12. | Würfelfarbe | blau |

| 3 | Maya | 07.09. | Würfelfarbe | gelb |

| 4 | Hans | 11.11. | Würfelfarbe | rosa |

| 5 | Hans | 26.02. | Summe Augen | 12 |

| 6 | Elke | 14.03. | Summe Augen | 17 |

| 7 | Jean | 30.12. | Summe Augen | 8 |

| 8 | Maya | 07.09. | Summe Augen | 23 |

| 9 | Hans | 11.11. | Summe Augen | 7 |

# Spalte new_index einfügen

messung1_long['new_index'] = messung1_long.groupby('variable').cumcount()

# casting

messung1_long_cast = pd.pivot(messung1_long, index = 'new_index', columns = 'variable', values = 'value')

# Spalten anordnen, Index zurücksetzen

messung1_long_cast = messung1_cast[['Name', 'Geburtstag', 'Würfelfarbe', 'Summe Augen']]

messung1_long_cast.reset_index(drop = True, inplace = True)

messung1_long_cast.rename_axis(None, axis = 1, inplace = True)

messung1_long_cast| Name | Geburtstag | Würfelfarbe | Summe Augen | |

|---|---|---|---|---|

| 0 | Hans | 26.02. | rosa | 12 |

| 1 | Elke | 14.03. | rosa | 17 |

| 2 | Jean | 30.12. | blau | 8 |

| 3 | Maya | 07.09. | gelb | 23 |

| 4 | Hans | 11.11. | rosa | 7 |

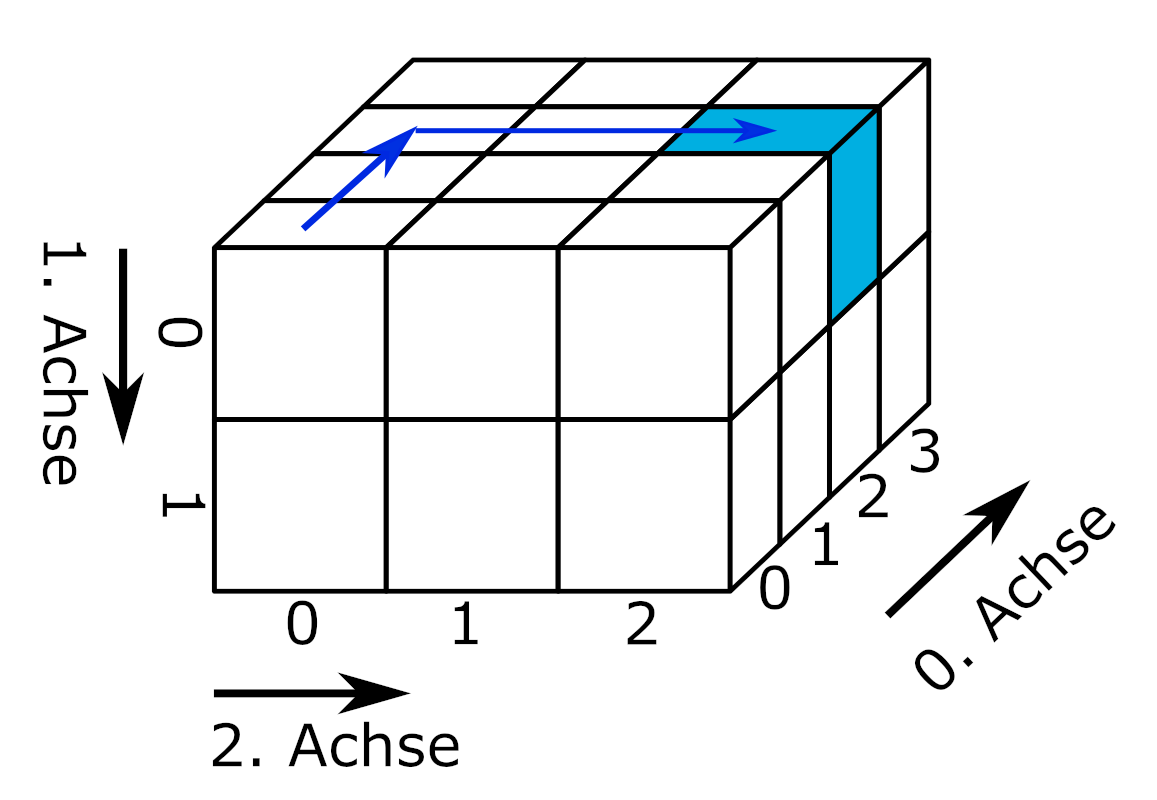

Drei- oder mehrdimensionale Datensätze organisieren komplexe Datenstrukturen in sogenannten Arrays. Arrays sind n-dimensionale Datenstrukturen und damit zugleich ein Oberbegriff. So ist eine Liste ein eindimensionales Array, eine Matrix ein zweidimensionales Array und eine Excel-Datei mit mehreren Arbeitsblättern für jährlich erhobene Umfragedaten ein 3-dimensionales Array (Arbeitsblätter, Zeilen, Spalten). Abhängig vom verwendeten Modul können Arrays ein oder mehrere Datentypen enthalten.

slicing von Marc Fehr ist lizensiert unter CC-BY-4.0 und abrufbar auf GitHub. Die Grafik wurde auf den gezeigten Teil beschnitten und die obenstehende Beschriftung entfernt. 2024

Für drei- und mehrdimensionale Datenstrukturen werden häufig spezialisierte Datenformate verwendet, die im Abschnitt Kapitel 7 behandelt werden. Dies hat unter anderem den Grund, dass so leichter verschiedene Datentypen verarbeitet und mit Metadaten (siehe Kapitel 2.4) dokumentiert werden können.

optional: Exkurs JSON https://docs.python.org/3/tutorial/inputoutput.html

Digitale Bilder liegen in Form eines dreidimensionalen Datensatzes vor. In Zeilen und Spalten liegen für jeden Pixel Farbwerte (Rot, Grün, Blau) und gegebenenfalls ein Alphawert vor (Rot, Grün, Blau, Alpha). Die Farbwerte liegen entweder im Bereich von 0 bis 1 oder von 0 bis 255 (8-Bit).

# Farbwerte für einen Pixel

[Rotwert, Grünwert, Blauwert]

# Eine Bildzeile mit drei Pixeln

[[Rotwert, Grünwert, Blauwert], [Rotwert, Grünwert, Blauwert], [Rotwert, Grünwert, Blauwert]]

# Ein Bild aus drei Zeilen und Spalten

[[[Rotwert, Grünwert, Blauwert], [Rotwert, Grünwert, Blauwert], [Rotwert, Grünwert, Blauwert]],

[[Rotwert, Grünwert, Blauwert], [Rotwert, Grünwert, Blauwert], [Rotwert, Grünwert, Blauwert]],

[[Rotwert, Grünwert, Blauwert], [Rotwert, Grünwert, Blauwert], [Rotwert, Grünwert, Blauwert]]]Bilddateien können mit der Funktion plt.imread() aus dem Modul matplotlib.pyplot eingelesen werden.

import matplotlib.pyplot as plt

logo = plt.imread(fname = '00-bilder/python-logo-and-wordmark-cc0-tm.png')

plt.imshow(logo)

Python Logo von Python Software Foundation steht unter der GPLv3. Die Wort-Bild-Marke ist markenrechtlich geschützt: https://www.python.org/psf/trademarks/. Das Werk ist abrufbar auf wikimedia. 2008

Die Struktur des Datensatzes kann mit dem Attribut .shape abgerufen werden.

print(type(logo), "\n")

print(logo.shape)<class 'numpy.ndarray'>

(144, 486, 4)Die Daten wurden als NumPy.ndarray eingelesen. Das Logo hat 144 Zeilen, 486 Spalten und liegt im RGBA-Farbraum vor. Ein Ausschnitt der Daten sieht so aus:

print(logo[50:52, 50:52, : ])[[[0.21568628 0.44705883 0.63529414 1. ]

[0.21568628 0.44705883 0.63529414 1. ]]

[[0.21568628 0.44705883 0.63529414 1. ]

[0.21176471 0.44313726 0.6313726 1. ]]]Über den Index der dritten Dimension können die Farbkanäle Rot, Grün und Blau ausgewählt und mit der Funktion plt.imshow(cmap = 'Greys_r') einzeln dargestellt werden. Das Argument cmap = 'Greys_r' weist die Funktion an, die invertierte Grauskala benutzen. Dadurch werden hohe Farbwerte hell und niedrige Farbwerte dunkel dargestellt. Stellen Sie die Farbkanäle Rot, Grün und Blau des Pythonlogos einzeln mit der Funktion plt.imshow(cmap = 'Greys_r') dar.

kanal = ["Rotkanal", "Grünkanal", "Blaukanal"]

plt.figure(figsize = (9, 6))

for i in range(3):

plt.subplot(1, 4, i + 1)

plt.imshow(logo[ :, :, i], cmap = 'Greys_r')

plt.title(label = kanal[i])

plt.colorbar(shrink = 0.15)

plt.tight_layout()

plt.show()

Möglicherweise wundern Sie sich, warum der Bildhintergrund in jedem Farbkanal schwarz ist. Die Ursache finden Sie im nächsten Tipp.

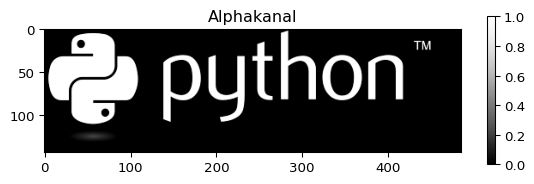

Der Bildhintergrund hat in allen Kanälen, auch im Alphakanal, den Farbwert 0. Dieser Teil des Bildes ist deshalb vollständig transparent und wird vom Hintergrund der Internetseite ausgefüllt. Der Bildhintergrund des Logos wirkt deshalb weiß.

# Alphakanal

plt.imshow(logo[ :, :, 3], cmap = 'Greys_r')

plt.title(label = 'Alphakanal')

plt.colorbar(shrink = 0.4)

plt.show()

# Die ersten zwei Zeilen und Spalten des Logos

print(logo[0:2, 0:2, : ])

[[[0. 0. 0. 0.]

[0. 0. 0. 0.]]

[[0. 0. 0. 0.]

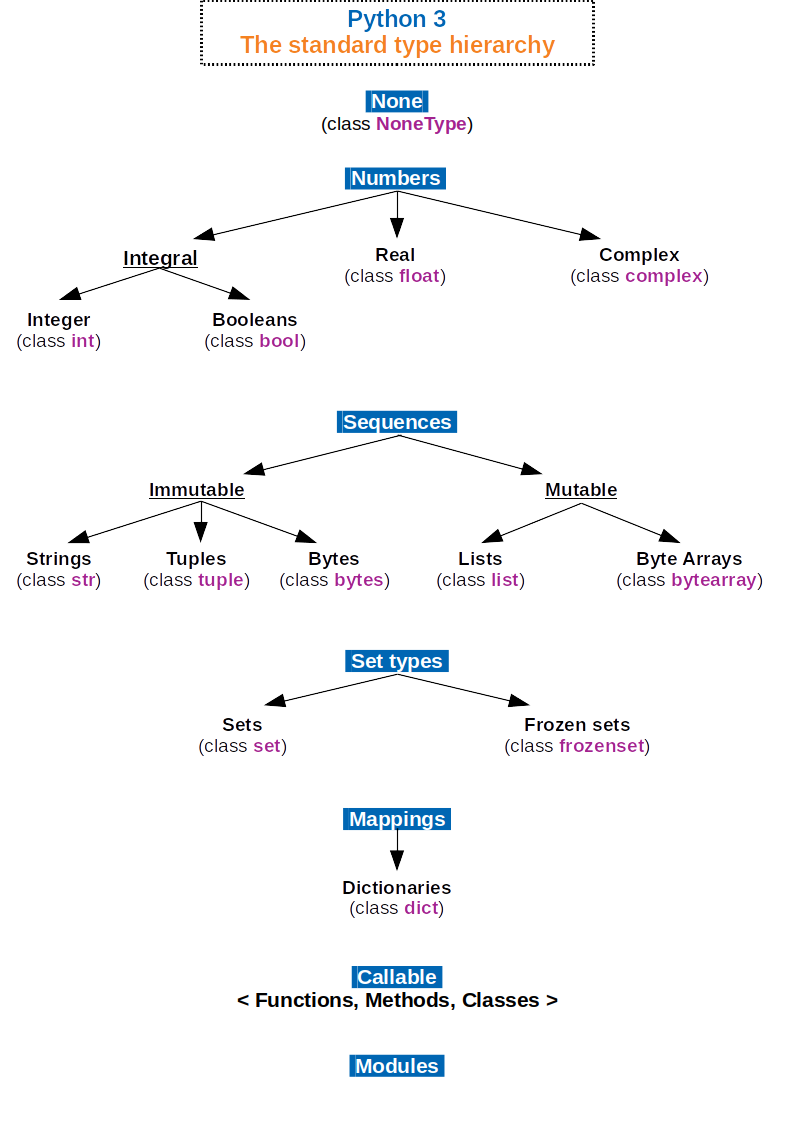

[0. 0. 0. 0.]]]Der Datentyp gibt an, wie die in einem Datensatz einhaltenen Werte von Python interpretiert werden sollen. Beispielsweise kann der Wert “1” ein Zeichen, eine Ganzzahl, einen Wahrheitswert, den Monat Januar oder die Ausprägung einer kategorialen Variablen repräsentieren. Python unterstützt als vielseitig einsetzbare Programmiersprache zahlreiche Datentypen, die den Kategorien: numerics, sequences, mappings, classes, instances and exceptions zugeordnet sind. Nähere Informationen dazu finden Sie in der Dokumentation.

Python 3. The standard type hierarchy. von Максим Пе ist lizensiert unter CC BY SA 4.0 und abrufbar auf wikimedia. 2018

Durch Module werden weitere Datentypen hinzugefügt. In der Datenanalyse häufig verwendete Datentypen sind:

Zahlen: Ganzzahl, Fließkommazahlen

Wahrheitswerte

Zeichenketten

Datums- und Uhrzeitangaben

Kategorie (aus dem Modul Pandas)

Der Datentyp bestimmt zum einen den zulässigen Wertebereich einer Variablen. Beispielsweise sind 0 und 13 zulässige Ganzzahlen, aber keine gültigen Kodierungen des Monats. Zum anderen definiert der Datentyp, welche Operationen mit den Werten zulässig sind und wie diese von Python ausgeführt werden. Dies betrifft Operatoren und Funktionen. Python enthält Funktionen, um den Datentyp eines Werts zu bestimmen und ggf. umzuwandeln (siehe w-Python).

# Der Operator + bewirkt die Addition von Zahlen

print(1 + 13)

# Der Operator + bewirkt auch das Verketten von strings

print(str(1) + str(13))14

113Die Sortierfunktion arbeitet abhängig vom Datentyp.

# Liste von Monatskürzeln erstellen

dates = pd.Series([ '07.06.2000', '12.01.2000', '11.02.2000', '04.09.2000', '10.03.2000', '03.10.2000', '09.04.2000', '08.05.2000', '06.07.2000', '05.08.2000', '02.11.2000', '01.12.2000'])

dates = pd.to_datetime(dates, format = '%d.%m.%Y');

print(f"Eine unsortierte Liste von Monatskürzeln:\n{list(dates.dt.strftime('%b'))}")

print(f"\nDie Liste alphabetisch sortiert:\n{sorted(list(dates.dt.strftime('%b')))}")

print(f"\nDie Liste als datetime-Objekt sortiert:\n{list(dates.sort_values().dt.strftime('%b'))}")Eine unsortierte Liste von Monatskürzeln:

['Jun', 'Jan', 'Feb', 'Sep', 'Mar', 'Oct', 'Apr', 'May', 'Jul', 'Aug', 'Nov', 'Dec']

Die Liste alphabetisch sortiert:

['Apr', 'Aug', 'Dec', 'Feb', 'Jan', 'Jul', 'Jun', 'Mar', 'May', 'Nov', 'Oct', 'Sep']

Die Liste als datetime-Objekt sortiert:

['Jan', 'Feb', 'Mar', 'Apr', 'May', 'Jun', 'Jul', 'Aug', 'Sep', 'Oct', 'Nov', 'Dec']Beim Einlesen von Datensätzen ist es wichtig, die korrekte Erkennung der Datentypen zu kontrollieren bzw. aktiv zu steuern. Weitere Methoden für die formale Prüfung des Datentyps und für die Kontrolle des Wertebereichs werden in Kapitel 3 vorgestellt.

Ein besonderer Datentyp ist der zur Repräsentation fehlender Werte. In Python wird zwischen nicht existenten und nicht definierten Werten unterschieden.

Der sogenannte Nullwert in Python ist None, das zu den definierten Schlüsselwörtern in Python gehört.

print(type(None))<class 'NoneType'>None repräsentiert nicht existente Werte und Objekte. Leere (aber existente) Objekte gehören nicht zum Datentyp None.

leere_liste = []

leere_liste == NoneFalseNone kann Funktionen als Argument übergeben oder von diesen als Rückgabewert ausgegeben werden. Operationen sind mit None jedoch nicht möglich.

# Operationen mit None führen zu Fehlermeldungen

try:

print(None + 1)

except TypeError as error:

print("Der übergebene Wert führt zu der Fehlermeldung:\n", error)

else:

print(None + 1)Der übergebene Wert führt zu der Fehlermeldung:

unsupported operand type(s) for +: 'NoneType' and 'int'Eine Ausnahme ist die Umwandlung in eine Zeichenkette.

# Eine Ausnahme ist die Umwandlung in strings

a = None

print("\nprint(a) gibt den Nullwert zurück:\n", a, sep = "")

print("\nstr(a) gibt eine Zeichenkette zurück:")

str(a)

print(a) gibt den Nullwert zurück:

None

str(a) gibt eine Zeichenkette zurück:'None'Um mit fehlenden Werten innerhalb eines Datensatzes arbeiten zu können, gibt es den Wert NaN, der zur Klasse der Fließkommazahlen gehört. NaN steht für Not a Number und repräsentiert undefinierte oder nicht darstellbare Werte. Beispielsweise berechnet die Methode pd.diff() die Differenz jedes Werts zu seinem Vorgänger. Da der erste Wert keinen Vorgänger hat, wird NaN erzeugt.

my_series = pd.Series([1, 2, 4, 8])

my_series.diff()0 NaN

1 1.0

2 2.0

3 4.0

dtype: float64Anders als None ist NaN kein Standardschlüsselwort in Python. Der Wert NaN wird erzeugt mit float('nan') oder float('NaN'), die Groß- und Kleinschreibung spielt keine Rolle. NaN hat also den Datentyp Fließkommazahl. Die Module math und NumPy bieten mit math.nan und np.nan ebenfalls Funktionen, um NaN zu erzeugen.

print(type(float('NaN')))<class 'float'>Mit dem Wert ‘NaN’ können Operationen ausgeführt werden. Das Ergebnis ist immer NaN.

print(float('NaN') + 1)nanEinige Funktionen können mit NaN als Platzhalter für fehlende Werte umgehen.

# Python-Basis

print("sum():", sum([1, 2, float('NaN'), 4]), "\n")

print("max():", max([1, 2, float('NaN'), 4]), "\n")

print("any():", any([1, 2, float('NaN'), 4]), "\n")

# Pandas

daten_mit_nan = pd.Series([1, 2, float('NaN'), 4])

print(daten_mit_nan + 1)

print("\nSumme des Datensates:", daten_mit_nan.sum())sum(): nan

max(): 4

any(): True

0 2.0

1 3.0

2 NaN

3 5.0

dtype: float64

Summe des Datensates: 7.0Die logische Abfrage fehlender Werte unterscheidet sich für None und NaN.

bool_values = [None, float('NaN')]

for element in bool_values:

bool_value = bool(element)

print("Wahrheitswert von", element, "ist", bool_value)Wahrheitswert von None ist False

Wahrheitswert von nan ist TrueDies gilt auch für die Wertgleichheit.

for element in bool_values:

result = element == element

print("Wertgleichheit von", element, "ist", result)Wertgleichheit von None ist True

Wertgleichheit von nan ist FalseNone und NaN sind pythonspezifische Repräsentationen für nicht existente oder nicht definierte Werte. In der Praxis werden fehlende Werte in Datensätzen auf unterschiedliche Weise gekennzeichnet.

In Datensätzen übliche Werte sind:

kein Eintrag, beispielsweise in kommaseparierten Dateien eine leere Zeichenkette ""

definierte Zeichenfolge: NA in der Programmiersprache R, NULL in der Datenbanksprache SQL, . in der Statistik-Software Stata

(mehrere) manuell gewählte Zeichen oder Ziffern außerhalb des zulässigen Wertebereichs wie -1, -88, -99 (häufig bei Umfragedaten)

Die Art der Kennzeichnung ist jeweils mit Vor- und Nachteilen verbunden. Eine definierte Zeichenfolge für fehlende Werte hilft dabei, Lücken im Datensatz von Fehlern bei der Datenerfassung zu unterscheiden. Dazu ist eine definierte Zeichenfolge wie “NA” besser als eine leere Zeichenkette geeignet. Manuell gewählte Werte erlauben es, bei der automatischen Auswertung eines Datensatzes abhängig von der Situation ein bestimmtes Verhalten für jede Variable festzulegen (z. B. Unterscheidung von nicht zutreffend, Aussage verweigert, weiß nicht, Interview abgebrochen keine Antwort).

Die Identifizierung und ggf. Bereinigung fehlender Werte ist ein wichtiger Schritt beim Einlesen strukturierter Datensätze. Dabei hilft es, die gängigen Kennzeichnungen für fehlende Werte zu kennen und sich über die Konventionen des jeweiligen Dateiformats bzw. der jeweiligen Disziplin zu informieren. Dennoch ist manchmal ein gewisser Spürsinn unerlässlich. Geeignete Funktionen zur Identifizierung fehlender Werte werden in Kapitel 3 vorgestellt.

Metadaten sind beschreibende Informationen eines Datensatzes. Metadaten geben beispielsweise an:

welche Datentypen ein Datensatz enthält,

verwendete Kodierschemen, Skalen oder mimimal und maximal zulässige Werte,

die Bedingungen, unter denen die Daten erhoben wurden,

Herkunft der Daten,

Beziehungen zwischen Variablen und Datensätzen,

urheberrechtliche Informationen und Lizenzhinweise.

(vgl. The HDF Group Help Desk)

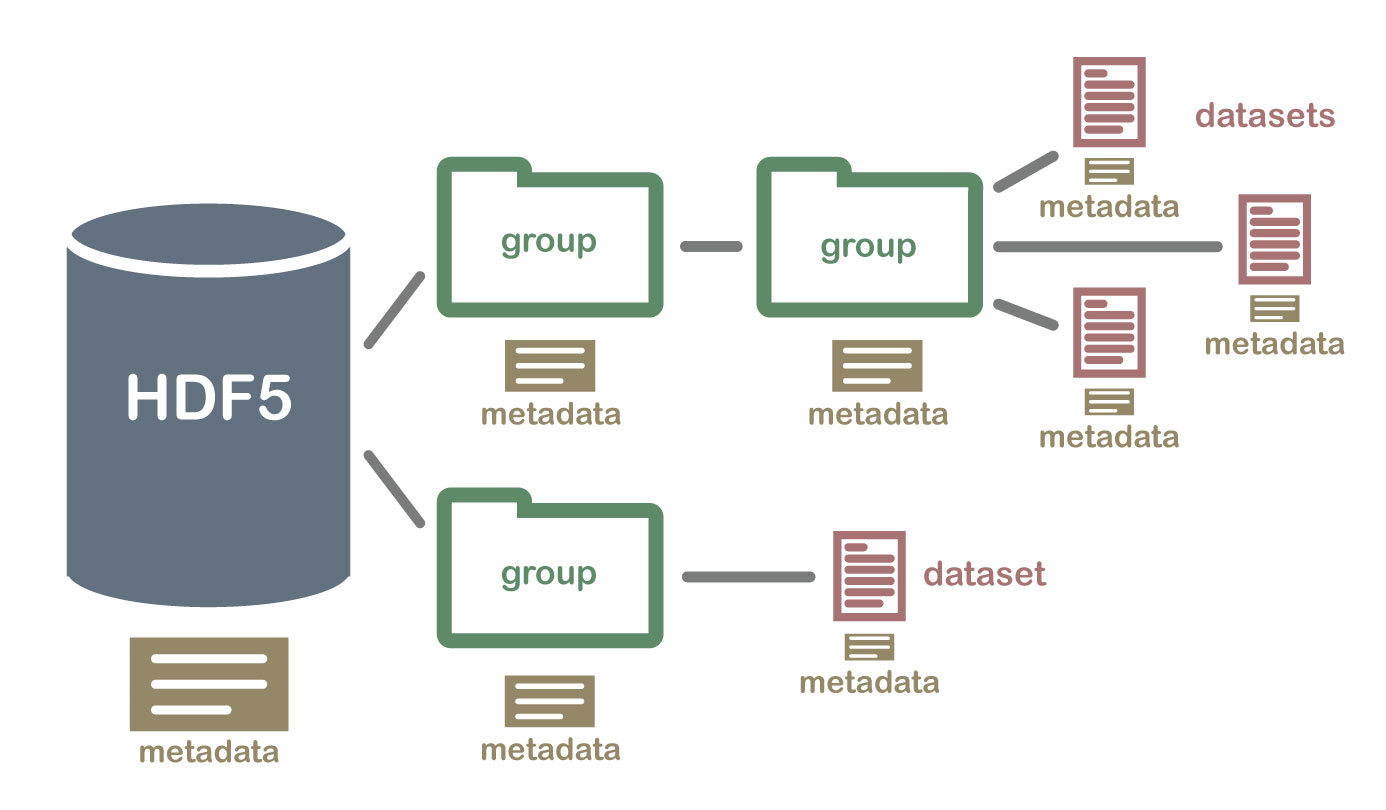

Spezialisierte Dateiformate wie netCDF oder HDF deklarieren Metadaten explizit in dafür vorgesehenen Feldern. Vielen Dateiformaten fehlt eine solche Funktion. Relevante Metadaten stehen deshalb häufig im Dateinamen, in Spaltenbeschriftungen, in zusätzlichen Tabellenblättern oder in separaten Dokumenten (die nicht immer zur Verfügung stehen).

Im Aufklapper ergänzen: Querverweis auf w-rechtliche Grundlagen Datenmanagement

Insbesondere vor dem Einlesen komplexer Datensätze sollten Begleitmaterialien, sofern vorhanden, studiert werden.

Hier Querverweis auf w-rechtliche Grundlagen Datenmanagement

Datensätze werden mit verschiedenen Zielstellungen angelegt, etwa dass eine bequeme Dateneingabe möglich ist. Dies führt aber häufig dazu, dass Datensätze für die skriptbasierte Datenanalyse zunächst aufwändig aufgeräumt werden müssen.

“Tidy datasets are all alike, but every messy dataset is messy in its own way.” (Wickham, Çetinkaya-Rundel, und Grolemund 2023, Kap. 5 Data tidying)

Tidy data ist ein System von Hadley Wickham, das dabei hilft, Datensätze in ein aufgeräumtes (tidy) Format zu bringen. Das Aufräumen von Datensätzen ist eine vorbereitende Tätigkeit mit dem Ziel, während der eigentlichen Datenanlyse möglichst wenig Zeit für das Umformen von Datenstrukturen aufwenden zu müssen. Dadurch soll ein größerer Fokus auf den inhaltlichen Aspekt der Datenanalyse ermöglicht werden. (Wickham, Çetinkaya-Rundel, und Grolemund 2023, Kap. 5 Data tidying)

“Das System tidy data besteht aus drei Regeln:

Jede Variable ist eine Spalte; jede Spalte ist eine Variabe.

Jede Beobachtung ist eine Zeile; jede Zeile ist eine Beobachtung.

Jeder Wert ist eine Zelle; jede Zelle ist ein einzelner Wert.”

(Wickham, Çetinkaya-Rundel, und Grolemund 2023, Kap. 5 Data tidying, eigene Übersetzung)

Tidy data bezieht sich auf zweidimensionale Datensätze, bietet aber auch darüber hinaus eine Orientierung, um unterschiedlich aufgebaute Datensätze strukturiert einzulesen und für die Datenanalyse vorzubereiten. Tidy data ist kein strikt zu befolgendes Regelwerk. Es ist völlig in Ordnung, eine andere Struktur zu wählen, wenn die Datenanalyse damit leichter durchgeführt werden kann.

Die Module NumPy und Pandas erlauben ein effizientes Arbeiten mit Datensätzen. Insbesondere das Lesen- und Schreiben von Dateien und die Verwaltung von Datentypen ist erheblich einfacher als mit der Python-Basis. Außerdem sind die vektorisierten Operationen vielfach schneller als Operationen mit Python. Das Modul Pandas basiert auf NumPy. In den folgenden Abschnitten werden beide Module behandelt.

Eine kurze Übersicht der Vor- und Nachteile:

NumPy: n-dimensionale Array-Struktur mit Unterstützung der am häufigsten verwendeten Datentypen sowie zahlreicher numerischer Formate für spezialisierte wissenschaftliche Berechnungen (siehe Dokumentation). Ein Array kann immer nur einen Datentyp haben und die Größe von Arrays ist unveränderlich. Dafür werden Operationen etwas schneller als in der DataFrame-Struktur von Pandas ausgeführt.

Querverweis auf w-NumPy

Pandas: 2-dimensionale DataFrame-Struktur im long- und wide-Format. DataFrames können mehrere Datentypen enthalten und die Größe von DataFrames ist veränderlich. Unterstützung von alphanummerischen Spalten- und Indexbeschriftungen. Direktes Abrufen von Dateien aus dem Internet möglich.

Querverweis auf w-Pandas

Für beide Module haben sich diese Kürzel etabliert:

import numpy as np

import pandas as pd

# Deklarieren der Anzahl der Nachkommastellen

pd.set_option("display.precision", 2)Ob Sie mit NumPy oder mit Pandas arbeiten, hängt von dem vorliegenden Datensatz und persönlichen Präferenzen ab.

Das Paket Pandas erlaubt es, Daten aus verschiedenen Quellen wie CSV-Dateien oder Excel-Tabellen und mit unterschiedlichen Datentypen in einen DataFrame zu laden. Anschließend können diese mit wenigen Befehlen untersucht und umstrukturiert werden. Komplexe Operationen wie das Umformen von Datensätzen, das Gruppieren und Aggregieren von Daten sowie das Filtern und Sortieren sind effizient möglich.

Bis auf wenige Ausnahmen sind Pandas und NumPy zueinander kompatibel. Es spricht nichts dagegen, Ihre Daten mit Pandas vorzubereiten und anschließend mit NumPy auszuwerten.

NumPy unterstützt folgende Datentypen:

| Datentyp NumPy-Array | Datentyp in Python |

|---|---|

| int_ | int |

| double | float |

| cdouble | complex |

| bytes_ | bytes |

| str_ | str |

| bool_ | bool |

| datetime64 | datetime.datetime |

| timedelta64 | datetime.timedelta |

In den meisten Fällen verwendet das Modul Pandas die NumPy-Datentypen. Pandas führt aber auch einige zusätzliche Datentypen ein. Eine vollständige Liste finden Sie in der Pandas Dokumentation. Die wichtigsten zusätzlichen Datentypen sind:

Kategorie dtype = 'category'

Zeitzonenbewusstes Datumsformat dtype = 'datetime64[ns, US/Eastern]'

In den Werkzeugbausteinen NumPy und Pandas haben Sie die Funktionen zum Lesen und Schreiben von Dateien kennengelernt.

In NumPy können Dateien mit der Funktion np.loadtxt() gelesen und mit der Funktion np.savetxt() geschrieben werden.

np.loadtxt(fname = data.txt, delimiter = ";", skiprows= #Reihen)

np.savetxt(fname = dateipfad, X = daten, header = kommentar, fmt='%5.2f')

In Pandas werden Dateien mit einer Reihe spezialisierter Funktionen gelesen und geschrieben, die einem einheitlichen Schema folgen. Funktionen zum Lesen von Dateien werden in der Form pd.read_csv und Funktionen zum Schreiben in der Form pd.to_csv aufgerufen. Mit Pandas können auch Dateien aus dem Internet abgerufen werden pd.read_csv(URL).

| Format Type | Data Description | Reader | Writer |

|---|---|---|---|

| text | CSV | read_csv | to_csv |

| text | Fixed-Width Text File | read_fwf | NA |

| text | JSON | read_json | to_json |

| text | HTML | read_html | to_html |

| text | LaTeX | Styler.to_latex | NA |

| text | XML | read_xml | to_xml |

| text | Local clipboard | read_clipboard | to_clipboard |

| binary | MS Excel | read_excel | to_excel |

| binary | OpenDocument | read_excel | NA |

| binary | HDF5 Format | read_hdf | to_hdf |

| binary | Feather Format | read_feather | to_feather |

| binary | Parquet Format | read_parquet | to_parquet |

| binary | ORC Format | read_orc | to_orc |

| binary | Stata | read_stata | to_stata |

| binary | SAS | read_sas | NA |

| binary | SPSS | read_spss | NA |

| binary | Python Pickle Format | read_pickle | to_pickle |

| SQL | SQL | read_sql | to_sql |

Der Datentyp bestimmt, wie bereits ausgeführt, den zulässigen Wertebereich einer Variablen, zulässige Operationen und die Ausführung von Operatoren und Funktionen in Python. Die Module NumPy und Pandas bieten eine Reihe von Funktionen, um den Datentyp von Variablen zu kontrollieren und festzulegen.

Hinweis: Der Datentyp datetime wird in Kapitel 4 behandelt.

Mit NumPy kann der Datentyp eines Arrays beim Einlesen einer Datei mit dem Argument dtype festgelegt werden np.loadtxt(fname = data.txt, dtype = 'float'). Das Argument dtype akzeptiert die Angabe eines Datentyps, Schlüsselwörter oder Kürzel. Weiter Informationen erhalten Sie in der NumPy Dokumentation.

| Datentyp | Schlüsselwort | Kürzel | dtype |

|---|---|---|---|

| Fließkommazahl | float | f8 | float64 |

| Ganzzahl | int | i | int32 |

| Wahrheitswert | bool | ? | bool |

| Datum | datetime64 | M | datetime64 |

| Zeichenkette | str | U | U + Ziffer zur Angabe der benötigten Bytes |

Der Datentyp eines Arrays kann mit dem Attribut np.dtype bestimmt werden. Der Datentyp eines Objekts kann mit der Methode np.array = np.array.astype() geändert werden.

Folgende Datei ist Ihnen aus dem w-NumPy bekannt.

dateipfad = '01-daten/TC01.csv'

daten = np.loadtxt(dateipfad)Prüfen Sie den dtype der Datei und legen Sie eine Kopie des Objekts mit Datentyp Ganzzahl an. Wie kann überprüft werden, ob bei der Umwandlung in Ganzzahlen Nachkommastellen abgeschnitten wurden?

# Ausgabe des Datentyps

print(daten.dtype)

# Umwandlung in Ganzzahl

daten_int = daten.astype('int')

# Prüfen auf Datenverlust

prüfsumme = daten - daten_int

print(f"Differenz daten - daten_int: {prüfsumme.sum()}")float64

Differenz daten - daten_int: 664.0Das Modul Pandas ist auf den Umgang mit unterschiedlichen Datentypen spezialisiert. Den Funktionen zum Einlesen von Daten kann mit dem Argument dtype der Datentyp übergeben werden. Für mehrere Spalten ist dies in Form eines Dictionaries in der Form {'Spaltenname': 'dtype'} möglich.

Das Atrribut zur Ausgabe des Datentyps heißt passenderweise pd.DataFrame.dtypes (angefügtes s beachten). Der Datentyp eines Pandas-Datenobjekts kann analog zu NumPy mit pd.Series = pd.Series.astype() geändert werden.

In einer Gruppe von 60 Meerschweinchen (1. Spalte ohne Beschriftung) wurde die Länge der zahnbildenden Zellen (Odontoblasten) in Micron gemessen (len). Den Tieren wurde zuvor Vitamin C in Form von Ascorbinsäure (VC) oder Orangensaft (VC) verabreicht (supp). Die Meerschweinchen erhielten Dosen von 0.5, 1 oder 2 Milligramm Vitamin C pro Tag (dose). Die Messdaten sind in der Datei ToothGrowth.csv gespeichert (Crampton 1947.)

Crampton, E. W. 1947. „THE GROWTH OF THE ODONTOBLASTS OF THE INCISOR TOOTH AS A CRITERION OF THE VITAMIN C INTAKE OF THE GUINEA PIG“. The Journal of Nutrition 33 (5): 491–504. https://doi.org/10.1093/jn/33.5.491

Lesen Sie die Datei wie folgt ein:

Die Spaltenbeschriftung der 1. Spalte soll mit der Beschriftung ‘ID’ ersetzt werden (ohne Anführungszeichen).

Die Spalten len und dose sollen mit geeigneten numerischen Datentypen, die Spalte supp als Kategorie eingelesen werden.

dateipfad = "01-daten/ToothGrowth.csv"

meerschweinchen = pd.read_csv(filepath_or_buffer = dateipfad, sep = ',', header = 0, \

names = ['ID', 'len', 'supp', 'dose'], dtype = {'ID': 'int', 'len': 'float', 'dose': 'float', 'supp': 'category'})

# Ausgabe jedes sechsten Werts

meerschweinchen.iloc[meerschweinchen.index % 6 == 0]| ID | len | supp | dose | |

|---|---|---|---|---|

| 0 | 1 | 4.2 | VC | 0.5 |

| 6 | 7 | 11.2 | VC | 0.5 |

| 12 | 13 | 15.2 | VC | 1.0 |

| 18 | 19 | 18.8 | VC | 1.0 |

| 24 | 25 | 26.4 | VC | 2.0 |

| 30 | 31 | 15.2 | OJ | 0.5 |

| 36 | 37 | 8.2 | OJ | 0.5 |

| 42 | 43 | 23.6 | OJ | 1.0 |

| 48 | 49 | 14.5 | OJ | 1.0 |

| 54 | 55 | 24.8 | OJ | 2.0 |

print(meerschweinchen.dtypes)ID int64

len float64

supp category

dose float64

dtype: objectPandas bietet einige praktische Funktionen, um den Aufbau eines Datensatzes zu beschreiben.

Das Attribut .columns gibt die Spaltenbeschriftungen als Liste zurück. Ebenfalls ist darüber ein Schreibzugriff möglich.

print(meerschweinchen.columns)

meerschweinchen.columns = ['ID', 'Länge', 'Verabreichung', 'Dosis']

print(meerschweinchen.columns)Index(['ID', 'len', 'supp', 'dose'], dtype='object')

Index(['ID', 'Länge', 'Verabreichung', 'Dosis'], dtype='object')Die Methode pd.DataFrame.describe() erzeugt eine beschreibende Statistik für einen DataFrame. Standardmäßig werden alle numerischen Spalten berücksichtigt. Mit dem Argument include können die zu berücksichtigenden Spalten vorgegeben werden. include = all berücksichtigt alle Spalten, was nicht unbedingt sinnvoll ist. Alternativ kann eine Liste zu berücksichtigender Datentypen übergeben werden. Das Argument exclude schließt auf die gleiche Weise Datentypen von der Ausgabe aus.

print(meerschweinchen.describe(), "\n")

print(meerschweinchen.describe(include = 'all'), "\n")

print(meerschweinchen.describe(include = ['float']), "\n") ID Länge Dosis

count 60.00 60.00 60.00

mean 30.50 18.81 1.17

std 17.46 7.65 0.63

min 1.00 4.20 0.50

25% 15.75 13.07 0.50

50% 30.50 19.25 1.00

75% 45.25 25.27 2.00

max 60.00 33.90 2.00

ID Länge Verabreichung Dosis

count 60.00 60.00 60 60.00

unique NaN NaN 2 NaN

top NaN NaN OJ NaN

freq NaN NaN 30 NaN

mean 30.50 18.81 NaN 1.17

std 17.46 7.65 NaN 0.63

min 1.00 4.20 NaN 0.50

25% 15.75 13.07 NaN 0.50

50% 30.50 19.25 NaN 1.00

75% 45.25 25.27 NaN 2.00

max 60.00 33.90 NaN 2.00

Länge Dosis

count 60.00 60.00

mean 18.81 1.17

std 7.65 0.63

min 4.20 0.50

25% 13.07 0.50

50% 19.25 1.00

75% 25.27 2.00

max 33.90 2.00

Die Methode pd.DataFrame.count() zählt alle vorhandenen Werte in jeder Spalte oder mit pd.DataFrame.count(axis = 'columns') in jeder Zeile.

meerschweinchen.count(axis = 'rows') # der Standardwert von axis ist 'rows'ID 60

Länge 60

Verabreichung 60

Dosis 60

dtype: int64Die Methode pd.DataFrame.info() erzeugt eine Beschreibung des Datensatzes.

meerschweinchen.info()<class 'pandas.core.frame.DataFrame'>

RangeIndex: 60 entries, 0 to 59

Data columns (total 4 columns):

# Column Non-Null Count Dtype

--- ------ -------------- -----

0 ID 60 non-null int64

1 Länge 60 non-null float64

2 Verabreichung 60 non-null category

3 Dosis 60 non-null float64

dtypes: category(1), float64(2), int64(1)

memory usage: 1.7 KBDie Methode pd.unique() listet alle einzigartigen Werte auf.

meerschweinchen['Dosis'].unique()array([0.5, 1. , 2. ])Pandas bietet einige praktische Funktionen, um eine eingelesene Datei zu kontrollieren. Machen Sie sich die Verwendung von pd.dtypes oder pd.DataFrame.info() zur Angewohnheit.

Das britische Energieministerium veröffentlicht Daten zu den Industriestrompreisen in den Mitgliedsändern der Internationalen Energieagentur.

Lesen Sie Tabellenblatt “5.3.1 (excl. taxes)” aus der Excel-Datei ‘skript/01-daten/table_531.xlsx’ mit Pandas ein. Schauen Sie in der Dokumentation der Funktion pd.read_excel nach, wie Sie das korrekte Tabellenblatt auswählen können. Stellen Sie sicher, dass alle Spalten mit einem numerischen Datentyp eingelesen werden.

Department for Energy Security & Net Zero. 2024. Energy Prices International Comparisons. Industrial electricity prices in the IEA. https://www.gov.uk/government/uploads/system/uploads/attachment_data/file/670121/table_531.xls

Überspringen der führenden Zeilen mit dem Argument header = 8. Auswahl des Tabellenblatts mit sheet_name = "5.3.1 (excl. taxes)" und Kontrolle der erkannten Datentypen mit taxes.dtypes

dateipfad = '01-daten/table_531.xlsx'

taxes = pd.read_excel(io = dateipfad, sheet_name = "5.3.1 (excl. taxes)", \

header = 8)

taxes.dtypesYear int64

Austria float64

Belgium float64

Denmark float64

Finland float64

France float64

Germany float64

Greece float64

Ireland float64

Italy float64

Luxembourg float64

Netherlands float64

Portugal float64

Spain float64

Sweden float64

United Kingdom float64

Australia float64

Canada float64

Czech Republic float64

Hungary float64

Japan float64

Korea float64

New Zealand float64

Norway float64

Poland float64

Slovakia float64

Switzerland float64

Republic of Türkiye object

USA float64

IEA median float64

UK relative to IEA median% float64

UK relative to IEA rank int64

UK relative to G7 rank int64

dtype: objectWerte in Spalte ‘Republic of Türkiye’ mit pd.unique() ansehen.

taxes['Republic of Türkiye'].unique()array(['..', 2.0436081749999997, 3.3248584439999993, 3.2947581129644483,

3.5628243387317866, 3.998334312, 3.838962582401693,

4.2138469457789975, 3.775503630575527, 3.2804905218375238,

3.783413840344277, 4.139259596071514, 4.196890742949158,

4.658509330911754, 5.552842625063031, 4.316920402166109,

4.1586205264300675, 4.765321921741988, 4.060617948410105,

3.9191433658651307, 4.223710389549368, 4.481407237836746,

4.629981488840797, 5.2657882806931235, 5.109009847145703,

4.585007793872617, 4.769921255774284, 4.419433670846949,

4.428906151745361, 6.171573537217762, 7.192920543071899,

7.962417550086158, 7.035941949054445, 7.622058781522502,

7.644892388451444, 6.47006818181818, 5.968380462724936,

6.379514692256784, 5.537541821623266, 5.248709303933227,

6.9100519994521274, 6.670900808798327, 5.864171132090749,

13.928251887312259, 11.123594768114717], dtype=object)Zeichenkette ‘..’ entfernen und Datentyp mit Methode pd.astype('float64') ändern.

Variante 1: als fehlenden Wert beim Einlesen deklarieren.

Variante 2: Nach dem Einlesen Indexposition bestimmen und Wert ersetzen. Das verkettete Slicing df["col"][row_indexer] = value wird mit der Pandas Version 3.0 nicht mehr unterstützt und gibt deshalb eine Fehlermeldung aus. Künftig ist folgende Syntax zu verwenden: df.loc[row_indexer, "col"] = value.

# Variante 1: '..' als fehlenden Wert deklarieren

# taxes = pd.read_excel(io = dateipfad, sheet_name = "5.3.1 (excl. taxes)", \

# header = 8, na_values = ['..'])

# Variante 2: Index des Werts bestimmen und mit np.nan überschreiben

indexposition = taxes['Republic of Türkiye'] == '..'

taxes.loc[indexposition, 'Republic of Türkiye'] = np.nan

taxes['Republic of Türkiye'] = taxes['Republic of Türkiye'].astype('float64')

taxes.dtypesYear int64

Austria float64

Belgium float64

Denmark float64

Finland float64

France float64

Germany float64

Greece float64

Ireland float64

Italy float64

Luxembourg float64

Netherlands float64

Portugal float64

Spain float64

Sweden float64

United Kingdom float64

Australia float64

Canada float64

Czech Republic float64

Hungary float64

Japan float64

Korea float64

New Zealand float64

Norway float64

Poland float64

Slovakia float64

Switzerland float64

Republic of Türkiye float64

USA float64

IEA median float64

UK relative to IEA median% float64

UK relative to IEA rank int64

UK relative to G7 rank int64

dtype: objectEine unerwartet als string oder object eingelesene Spalte weist häufig auf fehlende Werte hin, die durch Sonderzeichen gekennzeichnet sind. Die Module NumPy und Pandas bieten Funktionen, um fehlende Werte bereits beim Einlesen zu erkennen und umzuwandeln.

Hinweis: Maskierte NumPy-Arrays werden in Kapitel 6 behandelt.

Die NumPy-Funktion np.loadtxt() wird verwendet, um vollständige Datensätze einzulesen. Fehlende Werte im Datensatz können problematisch sein, da diese entweder zu Fehlermeldungen bezüglich des Datentyps führen oder übersprungen werden, sodass das NumPy-Array kürzer als der eingelesene Datensatz ist. Da NumPy-Arrays immer nur einen Datentyp und eine feste Länge haben, kann das bei der Durchführung von Operationen mit mehreren Arrays zu Fehlern führen.

Folgende Datei ist Ihnen aus dem w-NumPy bekannt.

dateipfad = '01-daten/TC01.csv'

daten_ohne_fehlende_werte = np.loadtxt(dateipfad)

print("Daten:", daten_ohne_fehlende_werte)

print("Struktur:", daten_ohne_fehlende_werte.shape, "dtype:", daten_ohne_fehlende_werte.dtype)Daten: [20.1 20.1 20.1 ... 24.3 24.2 24.2]

Struktur: (1513,) dtype: float64Angenommen, Sie haben eine zweite Messung durchgeführt und möchten die Differenz beider Datensätze berechnen. In der zweiten Messung haben Sensorfehler zu fehlenden Werten geführt, die mit -- markiert sind. Die Funktion np.loadtxt() kann jedoch mit fehlenden Werten nicht umgehen und gibt eine Fehlermeldung zurück.

dateipfad = '01-daten/TC01_double_hyphen.csv'

try:

daten_double_hypen = np.loadtxt(dateipfad)

except ValueError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print("Daten mit fehlenden Werten '--':", daten_double_hypen, "dtype:", daten_double_hypen.dtype) Die Eingabe führt zu der Fehlermeldung:

could not convert string '--' to float64 at row 1, column 1.Um Datensätze mit fehlenden Werten einzulesen, wird die Funktion np.genfromtxt(fname, delimiter = None, missing_values = None, filling_values = None) verwendet. Dieses durchläuft den Datensatz fname in zwei Schleifen, weshalb die Funktion langsamer als np.loadtxt() ist. Die erste Schleife teilt den Datensatz zeilenweise am optional übergebenen Trennzeichen delimiter in eine Zeichenkette auf. Die zweite Schleife konvertiert jede Zeichenkette in den passenden Datentyp. Mit den optionalen Argumenten missing_values und filling_values können der Funktion Zeichenfolgen übergeben werden, mit der fehlende Werte markiert sind bzw. ersetzt werden sollen. (NumPy Dokumentation)

dateipfad = '01-daten/TC01_double_hyphen.csv'

daten_double_hypen = np.genfromtxt(dateipfad, missing_values = '--', filling_values = np.nan)

print("\nDaten mit fehlenden Werten '--':", daten_double_hypen)

print("Struktur:", daten_double_hypen.shape, "dtype:", daten_double_hypen.dtype)

Daten mit fehlenden Werten '--': [20.1 nan 20.1 ... 24.3 24.2 24.2]

Struktur: (1513,) dtype: float64Durch die Umwandlung fehlender Werte in nan, sind Operationen mit gleichlangen NumPy-Arrays möglich.

daten_differenz = daten_ohne_fehlende_werte - daten_double_hypen

print(daten_differenz)[ 0. nan 0. ... 0. 0. 0.]Die Funktion np.genfromtxt() kann beliebige Zeichenketten als fehlenden Wert verarbeiten. Lediglich leere Zellen können problematisch sein, da deren Inhalt '\n' als Zeilentrenner verarbeitet wird.

Enthält eine Datei leere Zellen, können diese nicht eingelesen werden, da diese automatisch übersprungen werden.

# Datei ohne Markierung fehlender Werte

dateipfad = '01-daten/TC01_empty_lines.csv'

daten_empty_lines = np.genfromtxt(dateipfad, missing_values = '', filling_values = np.nan)

print("\nDaten mit fehlenden Werten '':", daten_empty_lines)

print("Struktur:", daten_empty_lines.shape, "dtype:", daten_empty_lines.dtype)

Daten mit fehlenden Werten '': [20.1 20.1 20.1 ... 24.3 24.2 24.2]

Struktur: (1511,) dtype: float64Das Array ist zwei Elemente kürzer. Die Subtraktion von einem längeren NumPy-Array scheitert mit einer Fehlermeldung.

try:

result = daten_ohne_fehlende_werte - daten_empty_lines

except ValueError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print(result)Die Eingabe führt zu der Fehlermeldung:

operands could not be broadcast together with shapes (1513,) (1511,) In diesem Fall muss auf die Stringbearbeitung aus der Python-Basis zurückgegriffen werden. Die bearbeitete Liste kann wie gewohnt mit np.genfromtxt() eingelesen werden.

# Einlesen über Datenobjekt

datenobjekt_empty_lines = open(dateipfad, 'r', encoding = 'utf-8')

daten_empty_lines = datenobjekt_empty_lines.readlines()

datenobjekt_empty_lines.close()

print("Das ausgelesene Datenobjekt (Ausschnitt):\n", daten_empty_lines[0:10])

# Stringbearbeitung mit replace('\n', '')

for i in range(len(daten_empty_lines)):

if daten_empty_lines[i] == '\n':

daten_empty_lines[i] = 'platzhalter'

else:

daten_empty_lines[i] = daten_empty_lines[i].replace('\n', '')

print("\nNach der Stringbearbeitung (Ausschnitt):\n", daten_empty_lines[0:10])

# Einlesen mit np.genfromtxt

daten_empty_lines = np.genfromtxt(daten_empty_lines, missing_values = 'platzhalter', filling_values = np.nan)

print("\nDaten mit fehlenden Werten '':", daten_empty_lines)

print("Struktur:", daten_empty_lines.shape, "dtype:", daten_empty_lines.dtype)Das ausgelesene Datenobjekt (Ausschnitt):

['# Temperatur in C\n', '20.1\n', '\n', '20.1\n', '20.1\n', '20.1\n', '\n', '20.1\n', '20.1\n', '20.1\n']

Nach der Stringbearbeitung (Ausschnitt):

['# Temperatur in C', '20.1', 'platzhalter', '20.1', '20.1', '20.1', 'platzhalter', '20.1', '20.1', '20.1']

Daten mit fehlenden Werten '': [20.1 nan 20.1 ... 24.3 24.2 24.2]

Struktur: (1513,) dtype: float64Besonders bei Dateien mit mehreren Spalten führen leere Zellen schnell zu Fehlern. Hier ist es erforderlich, den Zeichentrenner mit dem Argument delimiter zu spezifizieren. Aus der Dokumentation:

“When spaces are used as delimiters, or when no delimiter has been given as input, there should not be any missing data between two fields.” (NumPy Dokumentation)

Ohne Spezifikation des Arguments delimiter wird nur eine Spalte eingelesen, die ausschließlich np.nan enthält.

# ohne Spezifikation von delimiter

dateipfad = '01-daten/TC01_missing_values_multi_column.csv'

daten_empty_lines2 = np.genfromtxt(dateipfad, missing_values = '', filling_values = np.nan, ndmin = 2)

print("Struktur:", daten_empty_lines2.shape, "dtype:", daten_empty_lines2.dtype)

print("Die ersten drei Zeilen:\n", daten_empty_lines2[0:3])Struktur: (1513, 1) dtype: float64

Die ersten drei Zeilen:

[[nan]

[nan]

[nan]]Wird das Argument delimiter = ',' übergeben, wird die Datei korrekt eingelesen.

# mit Spezifikation von delimiter

daten_empty_lines2 = np.genfromtxt(dateipfad, delimiter = ',', missing_values = '', filling_values = np.nan, ndmin = 2)

print("Struktur:", daten_empty_lines2.shape, "dtype:", daten_empty_lines2.dtype)

print("\nDaten mit fehlenden Werten '':\n", daten_empty_lines2)Struktur: (1513, 2) dtype: float64

Daten mit fehlenden Werten '':

[[20.1 20.1]

[ nan nan]

[20.1 20.1]

...

[24.3 24.3]

[24.2 24.2]

[24.2 24.2]]Das Modul NumPy bietet Funktionen, um mit fehlenden Werten zu arbeiten.

np.nan erzeugt einen fehlenden Wert.

np.isnan() prüft auf einen fehlenden Wert und gibt einen Wahrheitswert bzw. ein NumPy-Array mit dtype bool zurück.

np.nonzero(np.isnan(array)) gibt ein Tuple zurück, das ein Array mit den Indexpositionen der Elemente mit dem Wert ‘nan’ enthält. Auf das Array kann mit np.nonzero(np.isnan(array))[0] zugegriffen werden. Je nach Situation kann die Umwandlung in eine Liste nützlich sein np.nonzero(np.isnan(array))[0].tolist().

Eine ähnliche Funktion ist np.argwhere(np.isnan(array)), deren Ausgabe aber nicht für das Slicing mehrdimensionaler Arrays geeignet ist (siehe folgendes Beispiel).

Eine andere Funktion, um die Indexposition eines Werts zu bestimmen, ist die Funktion np.argwhere(). Der Aufruf der Funktion np.argwhere(np.isnan(array)) gibt ein NumPy-Array mit den Indexposition Elemente mit dem Wert nan zurück.

array = np.array([[1, np.nan, np.nan], [4, 5, np.nan]])

print(array)

np.argwhere(np.isnan(array))[[ 1. nan nan]

[ 4. 5. nan]]array([[0, 1],

[0, 2],

[1, 2]])Das mit np.argwhere() erzeugte Array ist aber nicht geeignet, um Arraybereiche auszuwählen.

try:

array[np.argwhere(np.isnan(array))]

except IndexError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print(array[np.argwhere(np.isnan(array))]) Die Eingabe führt zu der Fehlermeldung:

index 2 is out of bounds for axis 0 with size 2Zum Vergleich mit np.nonzero()

try:

array[np.nonzero(np.isnan(array))]

except IndexError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print(array[np.nonzero(np.isnan(array))]) [nan nan nan]Die Auswahl von Array-Bereichen mit np.argwhere() funktioniert für eindimensionale Arrays.

array = np.array([1, np.nan, np.nan, 4, 5])

try:

array[np.argwhere(np.isnan(array))]

except IndexError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print(array[np.argwhere(np.isnan(array))]) [[nan]

[nan]]nan_to_num(x = array, nan = 0.0) ersetzt im Array x nan durch den Wert 0.0 oder durch den im Argument nan übergebenen Wert. (Hinweis: nan_to_num() ersetzt standardmäßig auch np.inf durch große positive sowie -np.inf durch große negative Zahlen.)Die Ersetzung eines bestimmten Werts ist auch durch die Auswahl bestimmter Array-Bereiche durch einen logischen Vektor möglich.

a = np.array([1, 2, 3, np.nan, 5, 6, np.nan])

b = np.isnan(a)

print(b)

a[b] = 0

print(a)[False False False True False False True]

[1. 2. 3. 0. 5. 6. 0.]Dabei können mehrere Bedingungen mit der Funktion np.logical_or(x1, x2) als logisches ODER kombiniert werden.

a = np.array([1, 2, 3, np.nan, 5, 6, np.nan])

bedingung1 = np.isnan(a)

bedingung2 = a >= 5

bedingung = np.logical_or(bedingung1, bedingung2)

a[bedingung] = 0

print(a)[1. 2. 3. 0. 0. 0. 0.]Auch ein logisches UND ist möglich (aber in Verbindung mit np.nan nicht sinnvoll). Der Operator * bewirkt das gleiche wie der logische Operator and oder die Funktion np.logical_and(x1, x2).

a = np.array([1, 2, 3, np.nan, 5, 6, np.nan])

bedingung1 = a < 4

bedingung2 = a >= 1

bedingung = bedingung1 * bedingung2

a[bedingung] = 0

print(a)[ 0. 0. 0. nan 5. 6. nan]np.delete(arr = array, obj) gibt ein neues (kürzeres) Array ohne die im Parameter obj spezifizierten Array-Bereiche zurück. Alle Elemente mit dem Wert nan werden so gelöscht: np.delete(array, obj = np.nonzero(np.isnan(array)))NumPy wandelt None nicht automatisch in nan um. NumPy kann den Datentyp des Objekts deshalb nicht bestimmen und gibt dtype=object aus:

np_array_with_none = np.array([1, 2, None, 4])

print(np_array_with_none, np_array_with_none.dtype)[1 2 None 4] objectAufgabe: Wie kann im Array np_array_with_none None durch np.nan ersetzt werden?

Eine logische Abfrage von None ist möglich. Auf diese Weise kann ein logisches Array erzeugt werden, das zur Auswahl der Indexpositionen verwendet wird, deren Werte ersetzt werden sollen.

np_array_with_none = np.array([1, 2, None, 4])

print(np_array_with_none)

np_array_with_nan = np_array_with_none.copy()

print(f"\nArray mit logischer Abfrage von None:\n{np_array_with_none == None}")

np_array_with_nan[np_array_with_none == None] = np.nan

print(f"\nArray mit None ersetzt durch nan:\n{np_array_with_nan, np_array_with_nan.dtype}")[1 2 None 4]

Array mit logischer Abfrage von None:

[False False True False]

Array mit None ersetzt durch nan:

(array([1, 2, nan, 4], dtype=object), dtype('O'))

Operationen mit nan ergeben immer nan. Deshalb gibt es in NumPy viele Funktionen, die nan automatisch ignorieren bzw. durch einen geeigneten Wert ersetzen. Diese sind bereits am Funktionsnamen erkennbar. Beispielsweise liefern np.nansum() und np.nancumsum() die Summe bzw. die kumulierte Summe eines Arrays. In der kumulierten Summe werden nan durch das laufende Ergebnis ersetzt. Eine vollständige Liste der NumPy-Funktionen finden Sie in der Dokumentation.

print(f"Array mit nan:\n{np_array_with_nan}\n")

print(f"Summe des Arrays:\n{np.sum(np_array_with_nan)}\n")

print(f"nan-Summe des Arrays:\n{np.nansum(np_array_with_nan)}\n")

print(f"kumulierte Summe des Arrays:\n{np.cumsum(np_array_with_nan)}\n")

print(f"kumulierte nan-Summe des Arrays:\n{np.nancumsum(np_array_with_nan)}\n")Array mit nan:

[1 2 nan 4]

Summe des Arrays:

nan

nan-Summe des Arrays:

7

kumulierte Summe des Arrays:

[1 3 nan nan]

kumulierte nan-Summe des Arrays:

[1 3 3 7]

Die Pandas-Funktionen zum Lesen von Dateien können mit fehlenden Werten umgehen. Standardmäßig werden folgende Werte als fehlende Werte erkannt:

['-1.#IND', '1.#QNAN', '1.#IND', '-1.#QNAN', '#N/A N/A', '#N/A', 'N/A', 'n/a', 'NA', '<NA>', '#NA', 'NULL', 'null', 'NaN', '-NaN', 'nan', '-nan', 'None', '']

Weitere Werte können mit dem Argument na_values = [] als fehlende Werte definiert werden. Mit dem Argument keep_default_na = False kann festgelegt werden, dass ausschließlich die in na_values = [] übergebenen Werte als fehlende Werte interpretiert werden sollen. Standardmäßig werden mit dem Argument na_filter = True auch leere Zellen als NA eingelesen. Vollständig leere Zeilen werden jedoch standardmäßig übersprungen. Dies kann mit dem Argument skip_blank_lines = False geändert werden. (Pandas Dokumentation)

dateipfad = '01-daten/TC01_double_hyphen.csv'

try:

daten_double_hypen = pd.read_csv(dateipfad, na_values = ['--'])

except ValueError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print("Daten mit fehlenden Werten '--':\n", daten_double_hypen, daten_double_hypen.shape) Daten mit fehlenden Werten '--':

# Temperatur in C

0 20.1

1 NaN

2 20.1

3 20.1

4 20.1

... ...

1508 24.3

1509 24.3

1510 24.3

1511 24.2

1512 24.2

[1513 rows x 1 columns] (1513, 1)Mit dem Argument skip_blank_lines = False werden leere Zeilen ebenfalls eingelesen.

dateipfad = '01-daten/TC01_empty_lines.csv'

try:

daten_empty_lines = pd.read_csv(dateipfad, skip_blank_lines = False)

except ValueError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print("Daten mit fehlenden Werten '':\n", daten_empty_lines, daten_empty_lines.shape) Daten mit fehlenden Werten '':

# Temperatur in C

0 20.1

1 NaN

2 20.1

3 20.1

4 20.1

... ...

1508 24.3

1509 24.3

1510 24.3

1511 24.2

1512 24.2

[1513 rows x 1 columns] (1513, 1)Pandas verwendet abhängig vom Datentyp verschiedene Werte zur Kennzeichnung fehlender Werte.

numpy.nan für NumPy-Datentypen. Hierbei wird der Datentyp automatisch in np.float64 oder object konvertiert.

pd.NA für Zeichenketten und Ganzzahlen. Der Datentyp bleibt erhalten.

Einlesen der Datei TC01_empty_lines.csv als string:

dateipfad = '01-daten/TC01_empty_lines.csv'

try:

daten_empty_lines = pd.read_csv(dateipfad, skip_blank_lines = False, dtype = 'string')

except ValueError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print("Daten mit fehlenden Werten '':\n", daten_empty_lines, daten_empty_lines.shape) Daten mit fehlenden Werten '':

# Temperatur in C

0 20.1

1 <NA>

2 20.1

3 20.1

4 20.1

... ...

1508 24.3

1509 24.3

1510 24.3

1511 24.2

1512 24.2

[1513 rows x 1 columns] (1513, 1)NA kann zwar auch als fehlender Wert für Gleitkommazahlen und andere NumPy Datentypen verwendet werden. Allerdings wird dafür ein Pandas-Datentyp benötigt (siehe das folgende Beispiel).

Eine pd.Series mit np.nan wird automatisch in dtype: float64 umgewandelt:

try:

test = pd.Series([1, 2, np.nan])

except TypeError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print(test) 0 1.0

1 2.0

2 NaN

dtype: float64Eine pd.Series mit pd.NA wird als dtype: object eingelesen:

try:

test = pd.Series([1, 2, pd.NA])

except TypeError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print(test) 0 1

1 2

2 <NA>

dtype: objectDer dtype kann für eine Series mit pd.NA festgelegt werden:

try:

test = pd.Series([1, 2, pd.NA], dtype = 'Int32')

except TypeError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print(test) 0 1

1 2

2 <NA>

dtype: Int32Abhängig vom Datentyp kommt es auf den korrekten dtype (NumPy oder Pandas) an, erkennbar an der Groß- und Kleinschreibung. pd.NA mit Numpy-Fließkommazahl:

try:

test = pd.Series([1, 2, pd.NA], dtype = 'float64')

except TypeError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print(test) Die Eingabe führt zu der Fehlermeldung:

float() argument must be a string or a real number, not 'NAType'pd.NA mit Pandas-Fließkommazahl:

try:

test = pd.Series([1, 2, pd.NA], dtype = 'Float64')

except TypeError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print(test) 0 1.0

1 2.0

2 <NA>

dtype: Float64np.nan mit Numpy-Fließkommazahl:

try:

test = pd.Series([1, 2, np.nan], dtype = 'float64')

except TypeError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print(test) 0 1.0

1 2.0

2 NaN

dtype: float64np.nan mit Pandas-Fließkommazahl:

try:

test = pd.Series([1, 2, np.nan], dtype = 'Float64')

except TypeError as error:

print("Die Eingabe führt zu der Fehlermeldung:\n", error)

else:

print(test) 0 1.0

1 2.0

2 <NA>

dtype: Float64

Die logische Abfrage fehlender Werte unterscheidet sich für None, np.nan und pd.NA.

bool_values = [None, float('nan'), pd.NA]

for element in bool_values:

try:

bool_value = bool(element)

except TypeError as error:

print(error)

else:

print("Wahrheitswert von", element, "ist", bool_value)Wahrheitswert von None ist False

Wahrheitswert von nan ist True

boolean value of NA is ambiguousDies gilt auch für die Wertgleichheit.

bool_values = [None, float('nan'), pd.NA]

for element in bool_values:

try:

result = element == element

except TypeError as error:

print(error)

else:

print("Wertgleichheit von", element, "ist", result)Wertgleichheit von None ist True

Wertgleichheit von nan ist False

Wertgleichheit von <NA> ist <NA>Das Modul Pandas wandelt None automatisch in nan um. Das Modul Pandas bietet wie das Modul NumPy verschiedene Funktionen, um mit fehlenden Werten zu arbeiten.

pd.NA erzeugt einen fehlenden Wert (Groß- und Kleinschreibung beachten: pd.na funktioniert nicht)

Die Funktionen pd.isnull() und pd.isna() prüfen auf einen fehlenden Wert und geben einen Wahrheitswert bzw. ein NumPy-Array mit dtype bool zurück. Die Funktionen pd.notna() und pd.notnull() prüfen den umgekehrten Fall.

Die Funktion np.nonzero(pd.isna()) verwendet die NumPy-Funktion np.nonzero() und gibt ein Array mit den Indexpositionen der Elemente mit fehlenden Werten zurück (die Pandas-Funktion pd.nonzero() wird nicht mehr unterstützt).

pd.Series.fillna(value = 0) ersetzt fehlende Werte mit dem im Argument value übergebenen Wert. Die Methoden pd.ffill() und pd.bfill() ersetzen fehlende Werte mit dem letzten bzw. dem nächsten gültigen Wert. Die Methode pd.Series.interpolate() ersetzt fehlende Werte durch Interpolation, wofür ein Datentyp definiert sein muss (dtype = object funktioniert nicht). Standardmäßig wird linear interpoliert, es stehen aber verschiedene Methoden zur Verfügung (siehe Pandas Dokumentation)

Die Methode pd.Series.dropna() gibt eine neue (kürzere) Series ohne fehlende Wert zurück.

Operationen mit pd.NA ergeben in der Regel pd.NA. Es gibt jedoch einige Ausnahmen:

print(pd.NA ** 0)

print(1 ** pd.NA)1

1Die Methode pd.Series.sum() behandelt pd.NA als 0, die Methode pd.Series.prod() als 1.

print(pd.Series([pd.NA]).sum())

print(pd.Series([pd.NA]).prod())0

1Reduzierende Methoden wie pd.Series.min() oder pd.Series.mean() sowie zusammenfassende Methoden wie pd.Series.cumsum() oder pd.Series.cumprod() überspringen pd.NA.

print(pd.Series([pd.NA]).min())

print(pd.Series([pd.NA]).mean())

print(pd.Series([pd.NA]).cumsum())

print(pd.Series([pd.NA]).cumprod())nan

nan

0 NaN

dtype: object

0 NaN

dtype: objectDas Verhalten von Methoden wie pd.Series.sum() und von Methoden wie pd.Series.min() hat für Datenreihen einen vergleichbaren Effekt, produziert für einzelne Werte jedoch unterschiedliche Ergebnisse.

Der Deutsche Wetterdienst misst deutschlandweit verschiedene Wetterdaten. In der Datei ‘produkt_st_stunde_20230831_20240630_01303.txt’ sind stündliche Stationsmessungen der Solarstrahlung in Essen-Bredeney gespeichert.

| Spaltenname | Beschreibung |

|---|---|

| STATIONS_ID | Stationsnummer |

| QN_592 | Qualitätsniveau der Daten |

| ATMO_LBERG | Stundensumme der atmosphärischen Gegenstrahlung |

| FD_LBERG | Stundensumme der diffusen solaren Strahlung |

| FG_LBERG | Stundensumme der Globalstrahlung |

| SD_LBERG | Stundensumme der Sonnenscheindauer |

| ZENIT | Zenitwinkel der Sonne 0 - 180 Grad |

Deutscher Wetterdienst. 2024. Stündliche Stationsmessung der Solarstrahlung (global/diffus) und der atmosphärischen Gegenstrahlung für Deutschland. https://opendata.dwd.de/climate_environment/CDC/observations_germany/climate/hourly/solar/stundenwerte_ST_01303_row.zip Die Spalten MESS_DATUM, MESS_DATUM_WOZ und eor wurden entfernt.

Bestimmen Sie die Kodierung fehlender Werte und ersetzen Sie diese durch np.nan bzw. pd.NA. Wie viele Werte wurden ersetzt?

Mit der Methode df.info() ist erkennbar, dass der Datensatz vollständig ist.

dateipfad = "01-daten/produkt_st_stunde_20230831_20240630_01303.txt"

solar = pd.read_csv(dateipfad, sep = ";")

solar.info()<class 'pandas.core.frame.DataFrame'>

RangeIndex: 7296 entries, 0 to 7295

Data columns (total 7 columns):

# Column Non-Null Count Dtype

--- ------ -------------- -----

0 STATIONS_ID 7296 non-null int64

1 QN_592 7296 non-null int64

2 ATMO_LBERG 7296 non-null float64

3 FD_LBERG 7296 non-null float64

4 FG_LBERG 7296 non-null float64

5 SD_LBERG 7296 non-null int64

6 ZENIT 7296 non-null float64

dtypes: float64(4), int64(3)

memory usage: 399.1 KBMit der Methode df.describe() wird die deskriptive Statistik für numerische Spalten erstellt.

solar.describe()| STATIONS_ID | QN_592 | ATMO_LBERG | FD_LBERG | FG_LBERG | SD_LBERG | ZENIT | |

|---|---|---|---|---|---|---|---|